GPU: что это в компьютере

Изучая технические характеристики компьютера, вы можете встретить такой термин как GPU. Данный термин обычно не объясняется простыми словами, поэтому пользователи редко понимают, что конкретно он означает. Иногда под GPU пользователи понимают видеокарту, хотя это не совсем верно. На самом деле GPU является частью видеокарты, а не самой видеокартой. В этом материале мы подробно расскажем о том, что такое GPU в компьютере, а также как узнать свой GPU и его температуру.

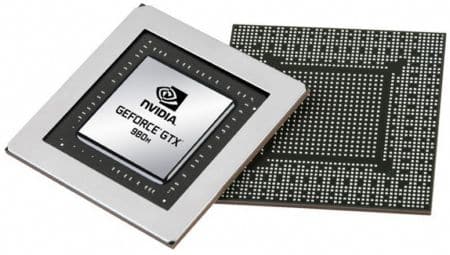

Аббревиатура GPU расшифровывается как Graphics Processing Unit, что можно перевести как устройство для обработки графики. Фактически GPU именно этим и является это отдельный модуль компьютера, который отвечает за обработку графики. В компьютере GPU может быть выполнен как отдельный кремниевый чип, который распаян на материнской или собственной отдельной плате (видеокарте), либо как часть центрального процессора или чипсета (северный мост).

Как выглядит GPU в компьютере.

Если GPU выполнен в качестве отдельного чипа, то его обычно называет графическим процессором, а если GPU является частью центрального процессора или чипсета, то часто для его обозначения используется термин интегрированная графика или встроенная графика.

В некоторых случаях под термином GPU понимают видеокарту, что не совсем верно, поскольку GPU – это именно чип (графический процессор), который занимается обработкой графики, а видеокарта — это целое устройство ответственное за обработку графики. Видеокарта состоит из графического процессора, памяти, имеет собственную плату и BIOS.

Другими словами, GPU – это графический процессор, который представляет собой кремниевый чип, на отдельной плате (видеокарте). Также под GPU может пониматься модуль, встроенный в центральный процессор (основной чип компьютера). В обоих случаях GPU занимается обработкой графики.

В современных условиях GPU часто используется не только для обработки графики, но и для решения других задач, которые могут быть обработаны с помощью графического процессора более эффективно, чем с помощью центрального процессора. Например, GPU используют для кодирования видео, машинного обучения, научных расчетов.

Дискретная и интегрированная видеокарты

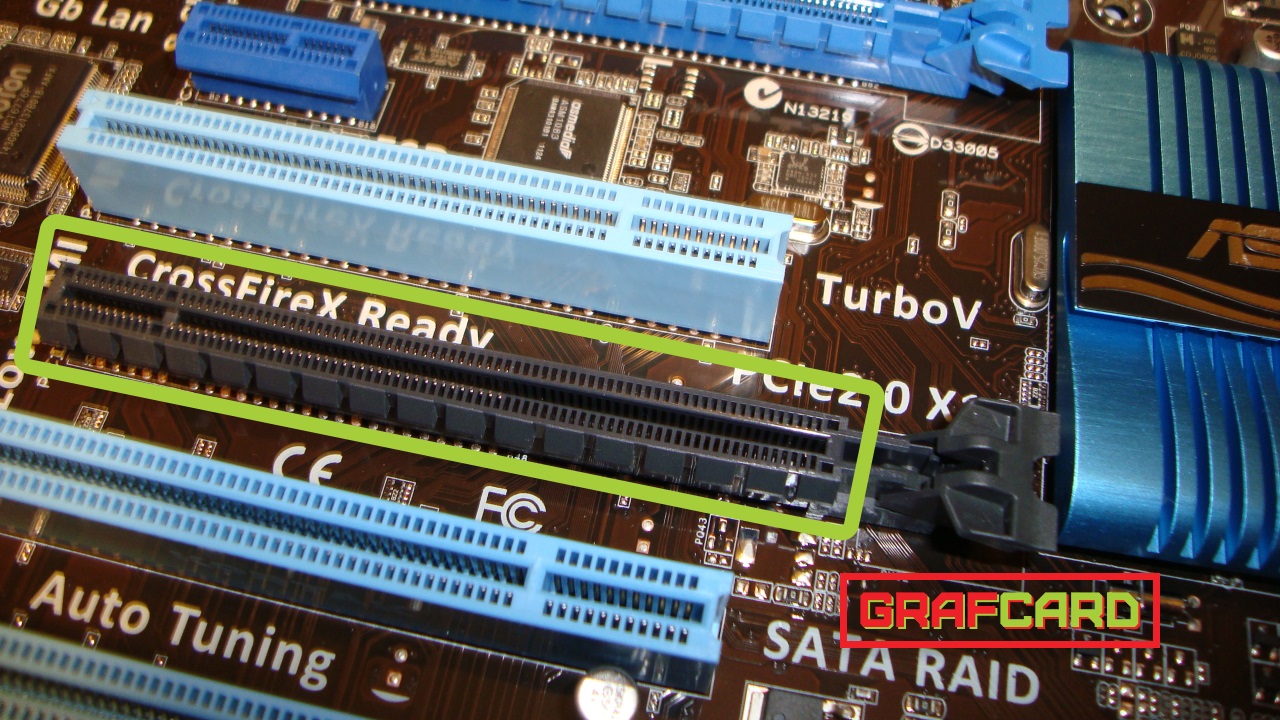

Полноценная видеокарта, представляющая собой самостоятельное устройство, называется дискретной. У нее отдельный графический процессор, собственная видеопамять, отдельные цепи питания, охлаждение и т.д. Все это расположено на отдельной плате, присоединяемой к материнской плате компьютера (в разъем PCI-E).

Как известно, «сердцем» любого компьютера является его центральный процессор. Многие процессоры, кроме вычислительных ядер, имеют в своем составе графический чип, способный выполнять функции видеокарты. И если в компьютере отдельной видеокарты нет, а за обработку и вывод на монитор графики отвечает встроенный в процессор видеочип, говорят, что у компьютера встроенная (интегрированная) видеокарта. Когда-то графические чипы встраивались не в процессор, а в материнскую плату, но это было очень давно и сейчас такие компьютеры уже не встречаются.

Интегрированная видеокарта позволяет сэкономить на приобретении дискретной карты. Возможностей встроенного в процессор графического чипа достаточно для выполнения офисных задач, просмотра и базовой обработки фото и видео, просмотра страниц Интернета, и даже развлечений в виде простых видеоигр. Некоторые интегрированные видеочипы сопоставимы по быстродействию с дискретными видеокартами начального уровня. Но геймерам и людям, работающим с графикой, хорошая дискретная видеокарта необходима по следующей причине.

Обработка и формирование различных графических данных, отображаемых на мониторе компьютера — очень сложная задача. В компьютерных играх этот процесс требует огромного количества точных расчетов: создание вершин, их собирание в примитивы (треугольники, линии, точки и т.д.), создание пиксельных блоков, операции освещения, затенения, текстурирования, присвоения цвета и т.д. Поскольку картинка в игре постоянно изменяется, все расчеты должны происходить на очень высокой скорости, чтобы обеспечить формирование достаточного количества кадров, выводимых за единицу времени.

Для человека комфортным является уровень не ниже 24 кадров в секунду (FPS, Frames Per Second). В компьютерных играх со сложной графикой встроенная видеокарта не способна обеспечить такой уровень быстродействия. Если FPS опускается ниже 24, человек замечает «торможение». Обычно, когда пользователь говорит, что его видеокарта «не тянет» какую-то игру, имеется ввиду именно ее неспособность вывести достаточное количество кадров в секунду.

Поскольку скорость обработки графики зависит не только от мощности видеокарты, но и от сложности обрабатываемой графики, остроту проблемы можно снизить, опустив до минимума качество графики в настройках игры. Но удовольствие от игрового процесса будет уже не то.

То же самое касается и профессиональной работы с графикой. Создание сцены, которая у дискретной видеокарты займет несколько минут, в случае с интегрированной графикой может затянуться на несколько часов или вообще закончиться ничем. Если проектирование, 3D-рендеринг и анимация является вашей работой, без хорошей дискретной видеокарты много заработать вряд ли получится.

История появления графических процессоров

Пожалуй, это был один из самых сложных и тернистых путей компьютерного прогресса, и начинался он, как могли подумать многие, не с вывода примитивной 2D или 3D графики, а с вывода самого простого текста на монохромный экран монитора.

Стоит обозначить, что мы не будет разбирать всю хронологию графических адаптеров, а обозначим только самые значимые и переломные моменты истории.

Итак, давайте начнём по порядку.

Самым первым графическим адаптером стал MDA (Monochrome Display Adapter), разработанный в 1981 году. MDA был основан на чипе Motorola 6845 и оснащен 4 КБ видеопамяти. Он работал только в текстовом режиме с разрешением 80×25 символов и поддерживал пять атрибутов текста: обычный, яркий, инверсный, подчёркнутый и мигающий. Никакой цветовой или графической информации он передавать не мог, и то, какого цвета будут буквы, определялось моделью используемого монитора.

Однако настоящим прародителем современных видеокарт принято считать CGA (Color Graphics Adapter), выпущенный компанией IBM в 1981 году. CGA мог работать как в текстовом режиме с разрешениями 80×25, так и в графическом с разрешениями до 640×200 точек и с возможностью отрисовки 16 цветов.

С момента появления первого цветного графического адаптера CGA в 1981 и вплоть до 1991 никаких революционных инноваций не происходило от слова «совсем». В основном разработчики и конструкторы аппаратных плат представляли небольшое увеличение разрешения, цветности изображения и т. д.

И только в 1991 году появилось такое понятие, как SVGA (Super VGA) — расширение VGA с добавлением новых режимов и дополнительного сервиса, например, возможности поставить произвольную частоту кадров. Число одновременно отображаемых цветов увеличивается до 65 536 (High Color, 16 бит) и 16 777 216 (True Color, 24 бита), появляются дополнительные как текстовые, так и визуальные режимы отображения информации. SVGA является фактическим стандартом видеоадаптеров где-то с середины 1992 года, после принятия ассоциацией VESA стандарта VBE (VESA BIOS Extention — расширение BIOS стандарта VESA) версии 1.0. До того момента практически все видеоадаптеры SVGA были несовместимы между собой.

Ну что, не устали еще? Если нет, предлагаю продолжить и перейти к разбору того, что из себя представляют интегрированные и дискретные видеокарты.

Интерфейсы подключения видеокарт

Интерфейсы подключения служат для соединения комплектующих и материнской платы. Различные периферийные устройства (сетевые и звуковые карты, ТВ-тюнеры и т.п.) как правило подключаются через PCI. Это стандартная шина ввода-вывода, но речь не о ней, т.к. для видеокарт используются другие слоты. До 2006 года был популярен интерфейс AGP, затем ему на смену пришёл PCIexpess (PCIe).

AGP был создан по технологиям PCI, но предназначен исключительно для видеокарт. Он отличается более высокой пропускной способностью. Последняя обновленная версия AGP 8x обладает пропускной способностью 2.1 Гб/с. Платы с AGP выпускались до 2006 года. Больше не производится, т.к. появился более совершенный интерфейс – PCIexpress.

PCI Express, отличии от AGP, обладает большей пропускной способностью, постоянно модернизируется и имеет обратную совместимость. На данный момент существуют 4 версии, следуя порядковому номеру. Самой последней является, PCIe 4.0. С каждым разом разработчики увеличивали пропускную способность интерфейса. Сейчас им удалось достигнуть отметки в 16 Гбит/с. Не стоит забывать про то, что PCI Express видеоадаптера и материнской платы зачастую не совпадают. Однако особого риска и страха здесь нет. Видеокарта будет работать на старой материнке, хоть и не сможет работать на всю свою мощность. При обратной совместимости вообще не возникает проблем.

Как выбирать?

Когда будете подбирать для себя видеоадаптер, обращайте внимание на такие характеристики:

- Тактовая частота. Указывается в мегагерцах. Чем цифра выше, тем больше информации за секунду сможет обработать устройство. Правда, не только она влияет на его результативность. Архитектура также имеет значение.

- Число вычислительных блоков. Они призваны обрабатывать задачи — шейдеры, отвечающие за вершинные, геометрические, пиксельные и универсальные расчеты.

- Быстрота заполнения (филлрейт). Этот параметр может рассказать, с какой скоростью GPU может вырисовывать картинку. Он делится на 2 вида: пиксельный (pixel fill rate) и текстурный (texel rate). На первый влияет количество ROP-блоков в структуре проца, а на второй — текстурных (TMU).

Обычно в последних моделях GPU первых блоков меньше. Они записывают рассчитанные видеоадаптером пиксели в буферы и смешивают их, что по-умному называется блендинг. TMU выполняют выборку и фильтрацию текстур и другой информации, требуемой для выстраивания сцены и общих расчетов.

Геометрические блоки

Раньше на них никто не обращал внимания, потому что виртуальные игры имели простую геометрию. Этот параметр стали учитывать после появления в DirectX 11 тесселяции. Не понимаете, о чем я? Давайте по порядку.

DirectX является средой (набором инструментов) для написания игр. Чтобы вы ориентировались в теме, скажу, что последняя версия продукта — 12-я, которая вышла в 2015 году.

Тесселяция — это деление плоскости на части для заполнения их новой информацией, что повышает реализм игры.

Таким образом, если вы захотите с головой окунуться в атмосферу Metro 2033, Crysis 2, HAWX 2 и т. п., при выборе GPU учитывайте количество геометрических блоков.

Память

Собрались брать новую видеокарту? Значит, вам нужно учесть еще несколько характеристик оперативки:

- Объем. Важность RAM несколько переоценена, так как не только ее емкость, но также тип и свойства влияют на производительность карты.

- Ширина шины. Это более весомый параметр. Чем шире, тем больше информации сможет отправить память чипу и наоборот за определенное время. Для воспроизведения игр необходимо минимум 128 бит.

- Частота. Тоже определяет пропускную способность оперативки. Но учтите, что память с 256-битной шиной и частотой 800 (3200) МГц работает продуктивнее, чем со 128 битами на 1000 (4000) МГц.

- Тип. Не буду грузить вас лишней информацией, а лишь назову оптимальные на сегодня типы — это GDDR 3 и 5 поколения.

Эпоха GPU

Для начала вспомним, что же такое GPU. Graphics Processing Unit — это графический процессор широко используемый в настольных и серверных системах. Отличительной особенностью этого устройства является ориентированность на массовые параллельные вычисления. В отличие от графических процессоров архитектура другого вычислительного модуля CPU (Central Processor Unit) предназначена для последовательной обработки данных. Если количество ядер в обычном CPU измеряется десятками, то в GPU их счет идет на тысячи, что накладывает ограничения на типы выполняемых команд, однако обеспечивает высокую вычислительную производительность в задачах, включающих параллелизм.

Первые шаги

Развитие видеопроцессоров на ранних этапах было тесно связано с нарастающей потребностью в отдельном вычислительном устройстве для обработки двух и трехмерной графики. До появления отдельных схем видеоконтроллеров в 70-х годах вывод изображения осуществлялся через использование дискретной логики, что сказывалось на увеличенном энергопотреблении и больших размерах печатных плат. Специализированные микросхемы позволили выделить разработку устройств, предназначенных для работы с графикой, в отдельное направление.

Следующим революционным событием стало появление нового класса более сложных и многофункциональных устройств — видеопроцессоров. В 1996 году компания 3dfx Interactive выпустила чипсет Voodoo Graphics, который быстро занял 85% рынка специализированных видеоустройств и стал лидером в области 3D графики того времени. После серии неудачных решений менеджмента компании, среди которых была покупка производителя видеокарт STB, 3dfx уступила первенство NVIDIA и ATI (позднее AMD), а в 2002 объявила о своем банкротстве.

Общие вычисления на GPU

В 2006 году NVIDIA объявила о выпуске линейки продуктов GeForce 8 series, которая положила начало новому классу устройств, предназначенных для общих вычислений на графических процессорах (GPGPU). В ходе разработки NVIDIA пришла к пониманию, что большее число ядер, работающих на меньшей частоте, более эффективны для параллельных нагрузок, чем малое число более производительных ядер. Видеопроцессоры нового поколения обеспечили поддержку параллельных вычислений не только для обработки видеопотоков, но также для проблем, связанных с машинным обучением, линейной алгеброй, статистикой и другими научными или коммерческими задачами.

Признанный лидер

Различия в изначальной постановке задач перед CPU и GPU привели к значительным расхождениям в архитектуре устройств — высокая частота против многоядерности. Для графических процессоров это заложило вычислительный потенциал, который в полной мере реализуется в настоящее время. Видеопроцессоры с внушительным количеством более слабых вычислительных ядер отлично справляются с параллельными вычислениями. Центральный же процессор, исторически спроектированный для работы с последовательными задачами, остается лучшим в своей области.

Для примера сравним значения в производительности центрального и графического процессора на выполнении распространенной задачи в нейронных сетях — перемножении матриц высокого порядка. Выберем следующие устройства для тестирования:

- CPU. Intel Xeon E5-2680 v4 — 28 потоков с HyperThreading, 2.4 GHZ;

- GPU. NVIDIA GTX 1080 — 2560 CUDA Cores, 1607 Mhz, 8GB GDDR5X.

В коде выше мы измеряем время, которое потребовалось на вычисление матриц одинакового порядка на центральном или графическом процессоре («Время выполнения»). Данные можно представить в виде графика, на котором горизонтальная ось отображает порядок перемножаемых матриц, а вертикальная — Время выполнения в секундах:

Линия графика, выделенная оранжевым, показывает время, которое требуется для создания данных в обычном ОЗУ, передачу их в память GPU и последующие вычисления. Зеленая линия показывает время, которое требуется на вычисление данных, которые были сгенерированы уже в памяти видеокарты (без передачи из ОЗУ). Синяя отображает время подсчета на центральном процессоре. Матрицы порядка менее 1000 элементов перемножаются на GPU и CPU почти за одинаковое время. Разница в производительности хорошо проявляется с матрицами размерами более 2000 на 2000, когда время вычислений на CPU подскакивает до 1 секунды, а GPU остается близким к нулю.

Более сложные и практические задачи эффективнее решаются на устройстве с графическими процессорами, чем без них. Поскольку проблемы, которые решают наши клиенты на оборудовании с GPU, очень разнообразны, мы решили выяснить, какие самые популярные сценарии использования существуют.

Зачем и где используется GPU

Первое, что приходит на ум для юзера, который хотя бы немного знаком с компьютерами — видеоигры. Это действительно так: киберспорт — отрасль, где графические адаптеры используются по максимуму. Сегодня сложно представить «серьезную» игру, которая реализована не в 3D.Большинство из игр в чем-то похожи: действие происходит в трехмерном мире от первого или третьего лица, а все это должна отрисовывать видеокарта. В играх других жанров, где используется изометрическая картинка, то есть вид сверху, например стратегиях или МОБА, давно уже используются такие же 3D модели.

Однако видеоигры — не единственная отрасль, где нужен GPU. Вспомните недавний хайп по поводу майнинга криптовалют, в частности биткоина, и последующее массовое появление на вторичном рынке графических адаптеров, ранее используемых для майнинга.

Сегодня эта тема теряет актуальность: трудолюбивые китайцы изобрели майнеры — девайсы, в которых нет графического чипа, но которые майнят даже лучше, чем видеокарты.

Также графический адаптер используется для обработки любого изображения — будь то просмотр видео на Ютубе или редактирование фотографий в «Фотошопе». Соответственно, если мощности GPU недостаточно, с запуском «прожорливых» в плане вычислительной мощности приложений могут быть проблемы.

Подписывайтесь на меня в социальных сетях, чтобы быть в курсе о поступлении новых материалов. До скорой встречи!