Почему компьютеры используют двоичный код

Двоичная система счисления (0 и 1) часто ассоциируется с компьютерами. Но почему это так? Почему компьютеры не могут просто использовать базу 10 вместо преобразования в двоичный файл и обратно? Разве не эффективнее использовать более высокую базу, поскольку двоичное представление (база 2) использует больше «пробелов»? Ответ довольно прост.

Что такое «цифровой»?

Современный «цифровой» компьютер, в отличие от старого «аналогового» компьютера, работает по принципу двух возможных состояний: «включено» и «выключено». Это непосредственно соответствует присутствию либо электрического тока, либо отсутствию указанного электрического тока. Состоянию » on «присваивается значение «1», в то время как состояние» off «присваивается значение»0».

Термин «двоичный» подразумевает «два». Таким образом, двоичная система счисления – это система чисел, основанная на двух возможных цифрах — 0 и 1. Каждая двоичная цифра, или «бит», представляет собой 0 или 1, который непосредственно соответствует одному «переключателю» в цепи. Добавьте достаточно этих «переключателей» вместе, и вы можете представить больше чисел. Таким образом, вместо 1 цифры, вы в конечном итоге с 8, чтобы сделать байт. (Байт-основная единица хранения, просто определяется как 8 бит; известные килобайты, мегабайты и гигабайты являются производными от байта, и каждый из них в 1,024 раза больше другого. Существует 1024-кратная разница в отличие от 1000-кратной разницы, потому что 1024 — это степень 2, а 1000 — нет.)

Двоичный использует больше памяти, чем десятичный?

На первый взгляд кажется, что двоичное представление числа 10010110 занимает больше места, чем его десятичное (основание 10) представление 150. В конце концов, первое — это 8 цифр, а второе — 3 цифры. Однако это недопустимый аргумент в контексте отображения чисел на экране, так как все они хранятся в двоичном формате! Единственная причина, по которой 150 «меньше», чем 10010110, заключается в том, как мы пишем его на экране (или на бумаге).

Увеличение базы уменьшит количество цифр, необходимых для представления любого заданного числа, но, беря непосредственно из предыдущей точки, невозможно создать цифровую схему, которая работает в любой базе, кроме 2, так как нет состояния между «включено» и «выключено» (если вы не попадете в квантовые компьютеры).

А как насчет восьмеричного и шестнадцатеричного?

Восьмеричное (основание 8) и шестнадцатеричное (основание 16) — это просто «ярлык» для представления двоичных чисел, поскольку оба эти основания являются степенями 2. 3 восьмеричные цифры = 2 шестнадцатеричные цифры = 8 двоичных цифр = 1 байт. Программисту проще представить 32-разрядное целое число, часто используемое для 32-разрядных значений цвета, как FF00EE99 вместо 11111111000000001110111010011001.

Недвоичные компьютеры

Представьте себе компьютер, основанный на базе 10. Тогда каждый «переключатель» будет иметь 10 возможных состояний. Они могут быть представлены цифрами (известными как «запреты» или «dits», что означает «десятичные цифры») от 0 до 9. В этой системе числа будут представлены в базе 10. Это невозможно с обычными электронными компонентами сегодня, но теоретически возможно на квантовом уровне.

Является ли эта система более эффективной? Предполагая, что «переключатели» стандартного двоичного компьютера занимают то же самое количество физического пространства (нанометров), что и эти переключатели base-10, компьютер base-10 мог бы вместить значительно больше вычислительной мощности в то же самое физическое пространство. Таким образом, хотя вопрос о том, что двоичный код «неэффективен», имеет некоторую обоснованность в теории, но не в практическом использовании сегодня.

Тогда почему все современные компьютеры используют двоичный код?

Простой ответ: компьютеры изначально не были предназначены для использования двоичных файлов. скорее, binary была определена как наиболее практичная система для использования с компьютерами, которые мы проектировали.

Полный ответ: мы используем только двоичный код, потому что в настоящее время у нас нет технологии для создания «переключателей», которые могут надежно удерживать более двух возможных состояний. (Квантовые компьютеры в данный момент точно не продаются.) Бинарная система была выбрана только потому, что довольно легко отличить наличие электрического тока от отсутствия электрического тока, особенно при работе с триллионами таких соединений. И использование любой другой базы чисел в этой системе нелепо, потому что система должна была бы постоянно конвертировать между ними. Вот и все.

Автор этого материала — я — Пахолков Юрий. Я оказываю услуги по написанию программ на языках Java, C++, C# (а также консультирую по ним) и созданию сайтов. Работаю с сайтами на CMS OpenCart, WordPress, ModX и самописными. Кроме этого, работаю напрямую с JavaScript, PHP, CSS, HTML — то есть могу доработать ваш сайт или помочь с веб-программированием. Пишите сюда.

Кодирование информации на компьютере

Мы познакомились с системами счисления — способами кодирования чисел. Числа дают информацию о количестве предметов. Эта информация должна быть закодирована, представлена в какой-то системе счисления. Какой из известных способов выбрать, зависит от решаемой задачи.

До недавнего времени на компьютерах в основном обрабатывалась числовая и текстовая информация. Но большую часть информации о внешнем мире человек получает в виде изображения и звука. При этом более важным оказывается изображение. Помните пословицу: “Лучше один раз увидеть, чем сто раз услышать”. Поэтому сегодня компьютеры начинают всё активнее работать с изображением и звуком. Способы кодирования такой информации будут обязательно нами рассмотрены.

Двоичное кодирование числовой и текстовой информации.

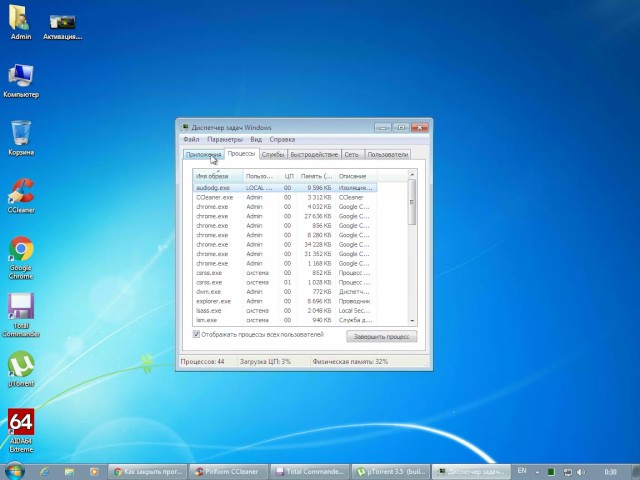

Любая информация кодируется в ЭВМ с помощью последовательностей двух цифр — 0 и 1. ЭВМ хранит и обрабатывает информацию в виде комбинации электрических сигналов: напряжение 0.4В-0.6В соответствует логическому нулю, а напряжение 2.4В-2.7В — логической единице. Последовательности из 0 и 1 называются двоичными кодами, а цифры 0 и 1 — битами (двоичными разрядами). Такое кодирование информации на компьютере называется двоичным кодированием. Таким образом, двоичное кодирование — это кодирование с минимально возможным числом элементарных символов, кодирование самыми простыми средствами. Тем оно и замечательно с теоретической точки зрения.

Инженеров двоичное кодирование информации привлекает тем, что легко реализуется технически. Электронные схемы для обработки двоичных кодов должны находиться только в одном из двух состояний: есть сигнал/нет сигнала или высокое напряжение/низкое напряжение.

ЭВМ в своей работе оперируют действительными и целыми числами, представленными в виде двух, четырёх, восьми и даже десяти байт. Для представления знака числа при счёте используется дополнительный знаковый разряд, который обычно располагается перед числовыми разрядами. Для положительных чисел значение знакового разряда равно 0, а для отрицательных чисел — 1. Для записи внутреннего представления целого отрицательного числа (-N) необходимо:

1) получить дополнительный код числа N заменой 0 на 1 и 1 на 0;

2) к полученному числу прибавить 1.

Так как одного байта для представления этого числа недостаточно, оно представлено в виде 2 байт или 16 бит, его дополнительный код: 1111101111000101, следовательно, -1082=1111101111000110.

Если бы ПК мог работать только с одиночными байтами, пользы от него было бы немного. Реально ПК работает с числами, которые записываются двумя, четырьмя, восемью и даже десятью байтами.

Начиная с конца 60-х годов компьютеры всё больше стали использоваться для обработки текстовой информации. Для представления текстовой информации обычно используется 256 различных символов, например большие и малые буквы латинского алфавита, цифры, знаки препинания и т.д. В большинстве современных ЭВМ каждому символу соответствует последовательность из восьми нулей и единиц, называемая байтом.

Байт – это восьмиразрядная комбинация нулей и единиц.

При кодировании информации в этих электронно-вычислительных машинах используют 256 разных последовательностей из 8 нулей и единиц, что позволяет закодировать 256 символов. Например большая русская буква «М» имеет код 11101101, буква «И» — код 11101001, буква «Р» — код 11110010. Таким образом, слово «МИР» кодируется последовательностью из 24 бит или 3 байт: 111011011110100111110010.

Количество бит в сообщении называется информационным объёмом сообщения. Это интересно!

Первоначально в ЭВМ использовался лишь латинский алфавит. В нём 26 букв. Так что для обозначения каждой хватило бы пяти импульсов (битов). Но в тексте есть знаки препинания, десятичные цифры и др. Поэтому в первых англоязычных компьютерах байт — машинный слог — включал шесть битов. Затем семь — не только чтобы отличать большие буквы от малых, но и для увеличения числа кодов управления принтерами, сигнальными лампочками и прочим оборудованием. В 1964 году появились мощные IBM-360, в которых окончательно байт стал равен восьми битам. Последний восьмой бит был необходим для символов псевдографики. Присвоение символу конкретного двоичного кода — это вопрос соглашения, которое фиксируется в кодовой таблице. К сожалению, существует пять различных кодировок русских букв, поэтому тексты, созданные в одной кодировке, не будут правильно отражаться в другой.

Хронологически одним из первых стандартов кодирования русских букв на компьютерах был КОИ8 («Код обмена информацией, 8 битный»). Наиболее распространённая кодировка — это стандартная кириллическая кодировка Microsoft Windows, обозначаемая сокращением СР1251 («СР» означает «Code Page» или «кодовая страница»). Фирма Apple разработала для компьютеров Macintosh собственную кодировку русских букв (Мас). Международная организация по стандартизации (International Standards Organization, ISO) утвердила в качестве стандарта для русского языка кодировку ISO 8859-5. Наконец, появился новый международный стандарт Unicode, который отводит на каждый символ не один байт, а два, и поэтому с его помощью можно закодировать не 256 символов, а целых 65536.

Все эти кодировки продолжают кодовую таблицу стандарта ASCII (Американский стандартный код для информационного обмена), кодирующую 128 символов.

Таблица символов ASCII:

| код | символ | код | символ | код | символ | код | символ | код | символ | код | символ |

| 32 | Пробел | 48 | . | 64 | @ | 80 | P | 96 | ‘ | 112 | p |

| 33 | ! | 49 | 0 | 65 | A | 81 | Q | 97 | a | 113 | q |

| 34 | « | 50 | 1 | 66 | B | 82 | R | 98 | b | 114 | r |

| 35 | # | 51 | 2 | 67 | C | 83 | S | 99 | c | 115 | s |

| 36 | $ | 52 | 3 | 68 | D | 84 | T | 100 | d | 116 | t |

| 37 | % | 53 | 4 | 69 | E | 85 | U | 101 | e | 117 | u |

| 38 | & | 54 | 5 | 70 | F | 86 | V | 102 | f | 118 | v |

| 39 | ‘ | 55 | 6 | 71 | G | 87 | W | 103 | g | 119 | w |

| 40 | ( | 56 | 7 | 72 | H | 88 | X | 104 | h | 120 | x |

| 41 | ) | 57 | 8 | 73 | I | 89 | Y | 105 | i | 121 | y |

| 42 | * | 58 | 9 | 74 | J | 90 | Z | 106 | j | 122 | z |

| 43 | + | 59 | : | 75 | K | 91 | [ | 107 | k | 123 | |

| 44 | , | 60 | ; | 76 | L | 92 | 108 | l | 124 | | | |

| 45 | — | 61 | 77 | M | 93 | ] | 109 | m | 125 | > | |

| 46 | . | 62 | > | 78 | N | 94 | ^ | 110 | n | 126 | ~ |

| 47 | / | 63 | ? | 79 | O | 95 | _ | 111 | o | 127 | DEL |

Двоичное кодирование текста происходит следующим образом: при нажатии на клавишу в компьютер передаётся определённая последовательность электрических импульсов, причём каждому символу соответствует своя последовательность электрических импульсов (нулей и единиц на машинном языке). Программа драйвер клавиатуры и экрана по кодовой таблице определяет символ и создаёт его изображение на экране. Таким образом, тексты и числа хранятся в памяти компьютера в двоичном коде и программным способом преобразуются в изображения на экране.

Двоичное кодирование графической информации.

С 80-х годов бурно развивается технология обработки на компьютере графической информации. Компьютерная графика широко используется в компьютерном моделировании в научных исследованиях, компьютерных тренажёрах, компьютерной анимации, деловой графике, играх и т.д.

Графическая информация на экране дисплея представляется в виде изображения, которое формируется из точек (пикселей). Всмотритесь в газетную фотографию, и вы увидите, что она тоже состоит из мельчайших точек. Если это только чёрные и белые точки, то каждую из них можно закодировать 1 битом. Но если на фотографии оттенки, то два бита позволяет закодировать 4 оттенка точек: 00 — белый цвет, 01 — светло-серый, 10 — тёмно-серый, 11 — чёрный. Три бита позволяют закодировать 8 оттенков и т.д.

Количество бит, необходимое для кодирования одного оттенка цвета, называется глубиной цвета.

В современных компьютерах разрешающая способность (количество точек на экране), а также количество цветов зависит от видеоадаптера и может изменяться программно.

Цветные изображения могут иметь различные режимы: 16 цветов, 256 цветов, 65536 цветов (high color), 16777216 цветов (true color). На одну точку для режима high color необходимо 16 бит или 2 байта.

Наиболее распространённой разрешающей способностью экрана является разрешение 800 на 600 точек, т.е. 480000 точек. Рассчитаем необходимый для режима high color объём видеопамяти: 2 байт *480000=960000 байт.

Для измерения объёма информации используются и более крупные единицы:

Следовательно, 960000 байт приблизительно равно 937,5 Кбайт. Если человек говорит по восемь часов в день без перерыва, то за 70 лет жизни он наговорит около 10 гигабайт информации (это 5 миллионов страниц — стопка бумаги высотой 500 метров).

Скорость передачи информации — это количество битов, передаваемых в 1 секунду. Скорость передачи 1 бит в 1 секунду называется 1 бод.

В видеопамяти компьютера хранится битовая карта, являющаяся двоичным кодом изображения, откуда она считывается процессором (не реже 50 раз в секунду) и отображается на экран.

Двоичное кодирование звуковой информации.

С начала 90-х годов персональные компьютеры получили возможность работать со звуковой информацией. Каждый компьютер, имеющий звуковую плату, может сохранять в виде файлов (файл — это определённое количество информации, хранящееся на диске и имеющее имя) и воспроизводить звуковую информацию. С помощью специальных программных средств (редакторов аудио файлов) открываются широкие возможности по созданию, редактированию и прослушиванию звуковых файлов. Создаются программы распознавания речи, и появляется возможность управления компьютером голосом.

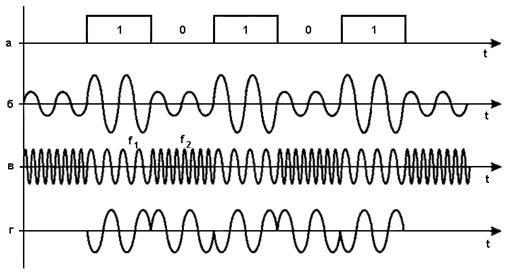

Именно звуковая плата (карта) преобразует аналоговый сигнал в дискретную фонограмму и наоборот, «оцифрованный» звук – в аналоговый (непрерывный) сигнал, который поступает на вход динамика.

При двоичном кодировании аналогового звукового сигнала непрерывный сигнал дискретизируется, т.е. заменяется серией его отдельных выборок — отсчётов. Качество двоичного кодирования зависит от двух параметров: количества дискретных уровней сигнала и количества выборок в секунду. Количество выборок или частота дискретизации в аудиоадаптерах бывает различной: 11 кГц, 22 кГц, 44,1 кГц и др. Если количество уровней равно 65536, то на один звуковой сигнал рассчитано 16 бит (216). 16-разрядный аудиоадаптер точнее кодирует и воспроизводит звук, чем 8-разрядный.

Количество бит, необходимое для кодирования одного уровня звука, называется глубиной звука.

Объём моноаудиофайла (в байтах) определяется по формуле:

При стереофоническом звучании объём аудиофайла удваивается, при квадрофоническом звучании – учетверяется.

По мере усложнения программ и увеличения их функций, а также появления мультимедиа-приложений, растёт функциональный объём программ и данных. Если в середине 80-х годов обычный объём программ и данных составлял десятки и лишь иногда сотни килобайт, то в середине 90-х годов он стал составлять десятки мегабайт. Соответственно растёт объём оперативной памяти.

Тест по информатике Основополагающие принципы устройства ЭВМ 10 класс

Тест по информатике Основополагающие принципы устройства ЭВМ 10 класс с ответами. Тест включает 5 заданий с выбором ответа.

1. Отметьте принципы, которые можно отнести к основополагающим принципам построения компьютеров

1) принцип многозадачности

2) принцип однородности памяти

3) принцип адресности памяти

4) состав основных компонентов вычислительной машины

5) принцип наличия способности к саморазвитию

2. Согласно принципу двоичного кодирования

1) компьютер может обрабатывать информацию, закодированную любым двоичным способом

2) вся информация, предназначенная для обработки на компьютере, а также программы её обработки представляются в виде двоичного кода

3) любая информация может быть закодирована на компьютере только 2 раза

3. Заполните пропуски в предложении.

… и данные размещаются в единой памяти, состоящей из …, имеющих свои номера (адреса). Это принцип … памяти.

1) информация, ячеек, единства

2) команды, микросхем, единства

3) команды, ячеек, адресности

4) информация, микросхем, адресности

4. Установите соответствие

1) шина адреса

2) шина данных

3) шина управления

А) передаются сигналы, управляющие обменом информацией между устройствами и синхронизирующие этот обмен

Б) используется для указания физического адреса, к которому устройство может обратиться для проведения операции чтения или записи

В) предназначена для передачи данных между узлами компьютера

5. Основополагающие принципы построения компьютеров были сформулированы независимо друг от друга двумя крупнейшими учёными XX века — …

1) Дж. фон Нейманом

2) С.А. Лебедевым

3) Клодом Шенноном

4) В.А. Котельниковым

Ответы на тест по информатике Основополагающие принципы устройства ЭВМ 10 класс

1. 234

2. 2

3. 3

4. 1Б 2В 3А

5. 12

Способы представления информации в компьютере

Любая информация (данные, команды) представляется в ЭВМ в виде двоичных кодов. Отдельные элементы двоичного кода, имеющие значение 0 или 1, называют разрядами или битами. Поэтому каждый из однородных элементов ячейки памяти компьютера, находящийся в одном из двух устойчивых состояний и хранящий один бит двоичного кода, называется разрядом. Структурной единицей представления двоичного кода являются: 8-разрядный формат— байт’, 32-разрядный формат — машинное слово’, 16-разрядный формат — полуслово и 64-разрядный формат — двойное слово.

Существует два основных типа представления чисел в компьютере — с фиксированной и плавающей точкой (запятой). Для представления целых чисел обычно используется первый формат, в котором положение точки зафиксировано после самого правого разряда. К достоинствам использования формата с фиксированной точкой относятся простота выполнения арифметических операций и высокая точность изобра жения чисел. К недостаткам — небольшой диапазон представления чисел.

Для компьютерного представления целых чисел можно использовать несколько различных типов данных, отличающихся количеством разрядов и наличием или отсутствием знакового разряда. Выпишем значение границ диапазонов для различных типов данных, указывая число разрядов и названия соответствующих типов в Turbo-Pascal.

Границы диапазонов для различных типов данных

Чтобы избавиться от ограничений по диапазону представления действительных чисел с помощью формата с фиксированной точкой (место отделения целой и дробной части фиксируется перед определенным разрядом), в современных компьютерах принят способ их представления с плавающей точкой.

Для представления чисел с плавающей точкой используется полулогарифмическая форма записи числа:

N = +mp ±q где р — основание системы счисления, q — порядок числа, т__

мантисса числа N.

Для установления однозначности при записи чисел принята нормализованная форма записи числа. Мантисса нормализованного числа может изменяться в диапазоне: / р -/ ) • 2 2 *» 1 = (1 — 2’ 24 ) • 2 26 ’ 1 =

= (1 — 2~ 24 ) — 2 63 = l-2 63 = 2 63 = (2 10 ) 6 -2 3 = (10 3 ) 6 • 2 3 = 10 21

31 30 29 28 27 26 25 24 23 22 21 0

знак знак m q

Минимальным числом по абсолютной величине, отличным от нуля будет

Nrnin = m,ni„ ? 2’- , где ттт = 2“’, = -(2 А -1)

= 2’ 1 • 2’ (? -1) = 2’ 1 • 2~ 63 = 2’ 64 = (2 10 )’ 6 • 2“ 4 = (10 3 ) -6 • 2’ 4 = 10 22

31 30 29 28 27 26 25 24 23 22 21 0

знак знак q т

Таким образом, числа с плавающей точкой позволяют увеличить диапазон обрабатываемых чисел, но при этом точность изображения чисел определяется только разрядами мантиссы. Чем больше отводится разрядов под мантиссу, тем выше точность представления числа. А чем больше разрядов занимает порядок, тем шире диапазон представляемых чисел.

Использование в компьютере представления чисел с плавающей точкой усложняет схему арифметического устройства. При сложении и вычитании чисел сначала производится выравнивание порядков, а затем сложение и вычитание мантисс выполняется так же, как над числами с фиксированной точкой. Умножение двух чисел с плавающей точкой сводится к сложению их порядков и перемножению мантисс, при этом предварительное выравнивание порядков не производится. При делении из порядка делимого вычитается порядок делителя, а мантисса делимого делится на мантиссу делителя.

После операций над порядками и мантиссами получается порядок и мантисса результата, но последняя может не удовлетворять ограничениям, накладываемым на мантиссы нормализованных чисел. Поэтому результат компьютерных арифметических операций нуждается в дополнительном преобразовании, называемом нормализацией.