Что такое GPU и как это связано с видео обработкой?

Вы любите поиграть в реалистичные игры на компе? Или посмотреть фильм в качестве, при котором четко видно каждую мелочь? Значит, вы должны представлять, что такое gpu в компьютере. Ничего о нем не знаете? Моя статья поможет вам избавиться от этого недоразумения ;-).

Что такое GPU?

Ни для кого не секрет, что центральный процессор, который является мозгом любого компьютера, имеет аббревиатуру CPU. Данное буквосочетание пошло из английского языка и расшифровывается оно как Central Processor Unit. Почему процессор называют центральным? Все очень просто. Данное «звание» вычислитель получил, потому что именно он управляет всеми подсистемами компьютера. Это и является основной функцией данного устройства. Управление осуществляется через чипсет и шины.

Если проводить аналогию с центральным процессором, то можно догадаться что такое GPU в домашнем компьютере. Данная аббревиатура расшифровывается как Graphic Processor Unit. Если говорить простым языком, то это графический чип, который в простонародье также именуется видеокартой (что неверно, так как видеокарта – отдельный аппаратный модуль).

Чем графический адаптер отличается от центрального процессора? Главное различие между этими двумя компонентам – архитектура. Структура CPU выполнена таким образом, что он обрабатывает порции информации последовательно, поочередно. А видеочип, в свою очередь, способен сразу же взаимодействовать с большими объемами данных. Это стало возможно благодаря огромному количеству ядер, которые проводят параллельные вычисления. Если с функциями ЦПУ мы уже разобрались, то появляется вопрос: а для чего нужен ГПУ? Ответ даст следующий раздел данной статьи.

История появления графических процессоров

Пожалуй, это был один из самых сложных и тернистых путей компьютерного прогресса, и начинался он, как могли подумать многие, не с вывода примитивной 2D или 3D графики, а с вывода самого простого текста на монохромный экран монитора.

Стоит обозначить, что мы не будет разбирать всю хронологию графических адаптеров, а обозначим только самые значимые и переломные моменты истории.

Итак, давайте начнём по порядку.

Самым первым графическим адаптером стал MDA (Monochrome Display Adapter), разработанный в 1981 году. MDA был основан на чипе Motorola 6845 и оснащен 4 КБ видеопамяти. Он работал только в текстовом режиме с разрешением 80×25 символов и поддерживал пять атрибутов текста: обычный, яркий, инверсный, подчёркнутый и мигающий. Никакой цветовой или графической информации он передавать не мог, и то, какого цвета будут буквы, определялось моделью используемого монитора.

Однако настоящим прародителем современных видеокарт принято считать CGA (Color Graphics Adapter), выпущенный компанией IBM в 1981 году. CGA мог работать как в текстовом режиме с разрешениями 80×25, так и в графическом с разрешениями до 640×200 точек и с возможностью отрисовки 16 цветов.

С момента появления первого цветного графического адаптера CGA в 1981 и вплоть до 1991 никаких революционных инноваций не происходило от слова «совсем». В основном разработчики и конструкторы аппаратных плат представляли небольшое увеличение разрешения, цветности изображения и т. д.

И только в 1991 году появилось такое понятие, как SVGA (Super VGA) — расширение VGA с добавлением новых режимов и дополнительного сервиса, например, возможности поставить произвольную частоту кадров. Число одновременно отображаемых цветов увеличивается до 65 536 (High Color, 16 бит) и 16 777 216 (True Color, 24 бита), появляются дополнительные как текстовые, так и визуальные режимы отображения информации. SVGA является фактическим стандартом видеоадаптеров где-то с середины 1992 года, после принятия ассоциацией VESA стандарта VBE (VESA BIOS Extention — расширение BIOS стандарта VESA) версии 1.0. До того момента практически все видеоадаптеры SVGA были несовместимы между собой.

Ну что, не устали еще? Если нет, предлагаю продолжить и перейти к разбору того, что из себя представляют интегрированные и дискретные видеокарты.

Что такое ускоренный процессор (APU)

APU – это термин, который AMD придумала для обозначения GPU, интегрированного в архитектуру процессора. И графические процессорные ядра, и стандартные процессорные ядра совместно используют один и тот же кэш и матрицу, и данные передаются по одной и той же шине.

Зачем создавать APU? Наличие как CPU, так и GPU в одном месте позволяет им работать более эффективно для увеличения вычислительной мощности. Аналогично, наличие интегрированных GPU и CPU обычно более энергоэффективно, чем наличие CPU и отдельного выделенного GPU. Многие современные APU достаточно мощны для неинтенсивных игр; однако APU почти всегда будет превзойден современным выделенным графическим процессором.

Первый APU, использующий кодовое имя Llano, был анонсирован AMD ещё в 2011 году, но проект работает с 2006 года. Если вам интересно, где всё это время был Intel, большинство их процессоров также используют интегрированную графику. Например, Intel Core-i7-8700K, обычно в паре с мощным выделенным графическим процессором, имеет встроенную графику Intel UHD 630. Однако термин APU не используется Intel, вероятно, из-за ассоциации с конкурирующим продуктом AMD.

Что такое графический процессор

GPU (аббревиатура с английского термина graphics processing unit) — компонент компьютера, игровой консоли, планшета или смартфона, который предназначен для рендеринга графики, то есть преобразует код в изображение, преимущественно 3D. Массовое применение таких девайсов началось с 2000 года.

До этого и разработчики, и пользователи обходились возможностями центрального процессора: игры и программы были слишком примитивны, чтобы задействовать дополнительный компонент. Отрисовка нескольких пикселей, какими и были первые игры и графические редакторы, не требует большой вычислительной мощности.

С началом развития 3D графики и появлением первых игр этого формата ситуация изменилась. Оказалось, что CPU, который прекрасно справляется с арифметическими операциями, даже не примитивной низко полигональной графике уже начинает «захлебываться».

Дальнейшее развитие к этому направлению привело к тому, что современная видеокарта, где и используется GPU — очень мощное устройство, которое идеально справляется с поставленными задачами. Оно и неудивительно: кат-сцены современных игр класса ААА уже практически не отличаются от 3D мультфильмов.

Что такое GPU?

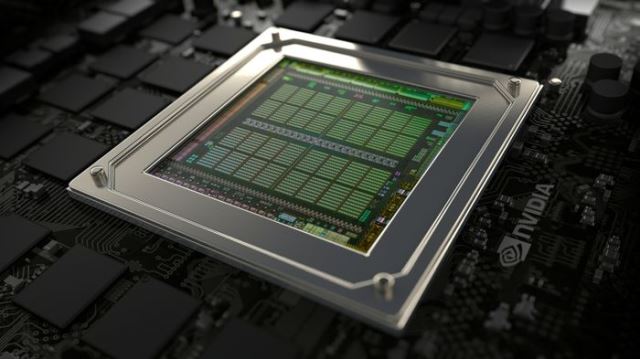

GPU (Graphics Processing Unit) — это специализированный тип микропроцессора, который оптимизирован для отображения графики и решения специфичных задач. Тактовая частота GPU существенно ниже, чем в CPU, но обычно он имеет больше ядер.

GPU это специальное устройство, сделанное для очень конкретной цели — работы с графикой. Рендеринг видео это выполнение простых математических операций миллионы раз, и GPU справляется с этой задачей лучше, чем центральный процессор. Графический процессор может иметь тысячи ядер, которые работают одновременно. Каждое ядро работает хоть и медленнее, чем ядра CPU, но оно настроено на более эффективную работу с математическими операциями, необходимыми для рендеринга видео. Этот мощный параллелизм позволяет графическим процессорам быстро обрабатывать сложную 3D графику необходимую для современных игр. (Читайте также «Почему тормозят компьютерные игры«)

Как узнать, какой графический процессор установлен в моем компьютере?

Получить информацию о графическом процессоре на своем компьютере можно в настройках устройства.

Если у вас Windows 10, нужно перейти в «Диспетчер устройств», затем выбрать пункт «Видеоадаптеры», где вы и увидите полный список графических процессоров, установленных на компьютере.

Затем нужно погуглить название, чтобы узнать, является ли процессор встроенным или дискретным.

Вы можете получить более подробную информацию о графическом процессоре вашего ПК и других характеристиках другими способами, включая использование сторонних программ.