Сравнение характеристики поколений эвм

Очередное революционное событие в электронике произошло в 1971 году, когда американская фирма Intel объявила о создании микропроцессора. Микропроцессор — это сверхбольшая интегральная схема, способная выполнять функции основного блока компьютера — процессора. Первоначально микропроцессоры стали встраивать в различные технические устройства: станки, автомобили, самолеты. Соединив микропроцессор с устройствами ввода-вывода, внешней памяти, получили новый тип компьютера: микроЭВМ. МикроЭВМ относятся к машинам четвертого поколения. Существенным отличием микроЭВМ от своих предшественников являются их малые габариты (размеры бытового телевизора) и сравнительная дешевизна. Это первый тип компьютеров, который появился в розничной продаже.

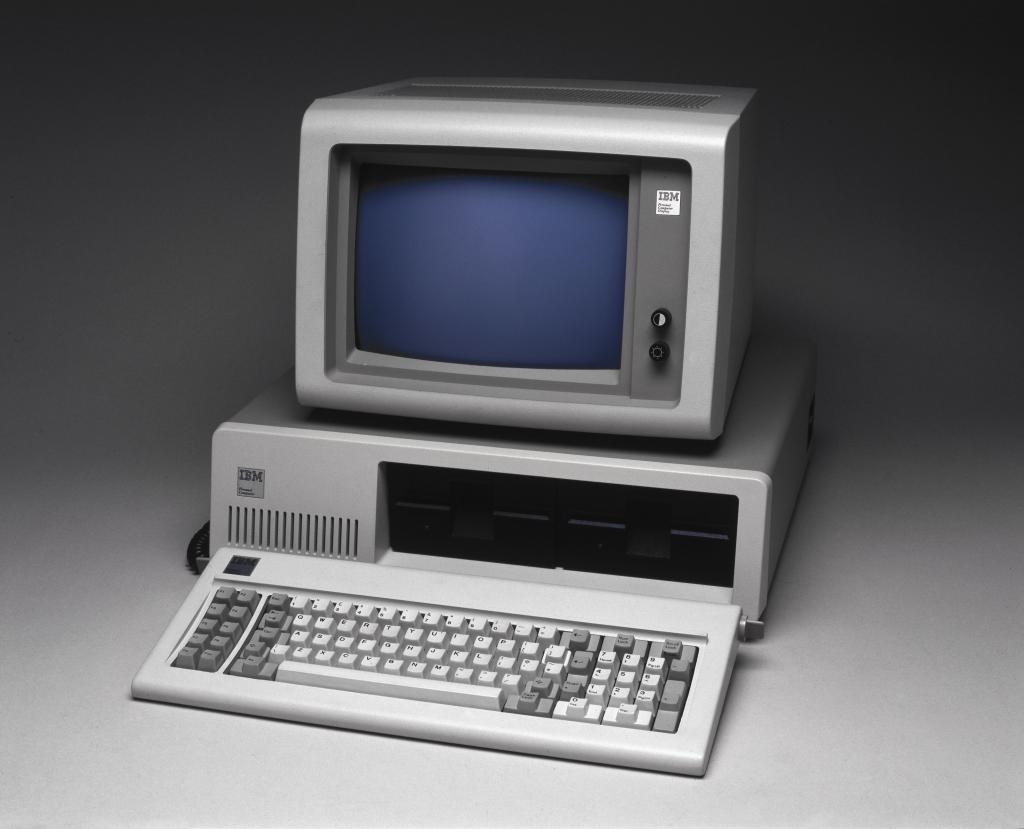

Самой популярной разновидностью ЭВМ сегодня являются персональные компьютеры (ПК). Первый ПК появился на свет в 1976 году в США. С 1980 года «законодателем мод» на рынке ПК становится американская фирма IBM. Ее конструкторам удалось создать такую архитектуру, которая стала фактически международным стандартом на профессиональные ПК. Машины этой серии получили название IBM PC (Personal Computer). Появление и распространение ПК по своему значению для общественного развития сопоставимо с появлением книгопечатания. Именно ПК сделали компьютерную грамотность массовым явлением. С развитием этого типа машин появилось понятие «информационные технологии», без которых уже становится невозможным обойтись в большинстве областей человеческой деятельности.

Другая линия в развитии ЭВМ четвертого поколения, это — суперкомпьютер. Машины этого класса имеют быстродействие сотни миллионов и миллиарды операций в секунду. Суперкомпьютер – это многопроцессорный вычислительный комплекс.

| Характеристики | Поколения ЭВМ | |||

| I | II | III | IV | |

| Годы применения | 1948-1958 | 1959-1967 | 1968-1973 | 1974-1982 |

| Элементная база | Лампы | Транзистор | МИС | БИС |

| Размеры | Значительные | Меньше размеров I поколения ЭВМ | Меньше размеров I и II поколений ЭВМ | Компактные |

| Количество ЭВМ в мире | Десятки | Тысячи | Десятки тысяч | Миллионы |

| Быстродействие | 10-20 тыс. операций в секунду | 100-1000 тыс. операций в секунду | 1-10 млн. операций в секунду | 10-100 млн. операций в секунду |

| Объём оперативной памяти | 2 Кбайта | 2-32 Кбайта | 64 кбайта | 2-5 мбайт |

| Типичные модели | МЭСМ, БЭСМ-2 | БЭСМ-6, Минск-2 | IBM-360, IBM-370, ЕС ЭВМ, СМ ЭВМ | IBM-PC, Apple |

| Носители информации | Перфокарта, перфолента | Магнитная лента | Диск | Гибкий и лазерный диски |

«Сравнительные характеристики поколений ЭВМ»

Не нашли то, что искали? Воспользуйтесь поиском:

Лучшие изречения: Студент – человек, постоянно откладывающий неизбежность. 10824 – | 7386 – или читать все.

Появлению современных компьютеров, которыми мы привыкли пользоваться, предшествовала целая эволюция в развитии вычислительной техники. Согласно распространенной теории, развитие индустрии ЭВМ шло на протяжении нескольких отдельных поколений.

Современные эксперты склонны считать, что их шесть. Пять из них уже состоялись, еще одно – на подходе. Что именно под термином «поколение ЭВМ» понимают IT-специалисты? Каковы принципиальные различия между отдельными периодами развития вычислительной техники?

2. Архитектура персонального компьютера

Современные персональные компьютеры различаются по своим размерам, конструкции, разновидностям используемых микросхем и модулей памяти, другим характеристикам. В то же время все они имеют единое функциональное устройство, единую архитектуру — основные узлы и способы взаимодействия между ними (рис. 2.7).

Архитектура — это наиболее общие принципы построения компьютера, отражающие программное управление работой и взаимодействием его основных функциональных узлов.

На рисунке 2.7 изображены хорошо известные вам узлы современного компьютера:

процессор,

внутренняя память,

устройства ввода,

устройства вывода и внешняя память.

Рис. 2.7. Функциональная схема компьютера (К — контроллер)

Обмен данными между устройствами компьютера осуществляется с помощью магистрали.

Магистраль (шина) — устройство для обмена данными между устройствами компьютера.Магистраль состоит из трёх линий связи:

• шины адреса, используемой для указания физического адреса, к которому устройство может обратиться для проведения операции чтения или записи;

• шины данных, предназначенной для передачи данных между узлами компьютера;

• шины управления, по которой передаются сигналы, управляющие обменом информацией между устройствами и синхронизирующие этот обмен.

В компьютерах, имевших классическую фон-неймановскую архитектуру, процессор контролировал все процессы ввода/вывода. При этом быстродействующий процессор затрачивал много времени на ожидание результатов работы от значительно более медленных внешних устройств. Для повышения эффективности работы процессора были созданы специальные электронные схемы, предназначенные для обслуживания устройств ввода/вывода или внешней памяти.

Контроллер — это специальный микропроцессор, предназначенный для управления внешними устройствами: накопителями, мониторами, принтерами и т. д.

Благодаря контроллерам данные по магистрали могут передаваться между внешними устройствами и внутренней памятью напрямую, минуя процессор. Это приводит к существенному снижению нагрузки на центральный процессор и повышает эффективность работы всей вычислительной системы.

Современные компьютеры обладают магистрально-модульной архитектурой, главное достоинство которой заключается в возможности легко изменить конфигурацию компьютера путём подключения к шине новых или замены старых внешних устройств.

Если спецификация на шину (детальное описание всех её параметров) является открытой (опубликованной), то производители могут разработать и предложить пользователям разнообразные дополнительные устройства для компьютеров с такой шиной. Подобный подход называют принципом открытой архитектуры. Благодаря ему пользователь может собрать именно такую компьютерную систему, которая ему нужна.

Реализация принципов фон Неймана на практике

Первая ЭВМ построенная на принципах фон Неймана называлась Electronic Delay Storage Automatic calculator ( автоматический калькулятор с электронной памятью на линиях задержки ) — EDSAC. Она была построена в $1949$ году в Кембриджском университете в Великобритании. Все последующие ЭВМ первого и второго поколения также соответствовали описанной архитектуре. В СССР первой ЭВМ близкой к принципам фон Неймана была МЭСМ, построенная под руководством С.А.Лебедева в $1951$ году.

В современных компьютерах по-прежнему выполняются принцип использования двоичной системы счисления, принцип автоматической работы и принцип хранимости программы. Однако, остальные принципы выполняются далеко не во всех современных ЭВМ.

Существуют модели компьютеров, которые различают команды и данные, нарушая принцип совместного использования памяти. В этих моделях, кроме самой информации (команды или данных), каждая ячейка памяти хранит еще и специальную метку, которая указывает тип содержимого ячейки. В целях экономии памяти такая метка приписывается не каждой ячейке, а целой последовательности ячеек. И таким образом, различается сегмент команд и сегмент данных.

Многие современные модели ЭВМ нарушают принцип однородности и линейности памяти. Например, память либо может состоять из двух частей с независимой адресацией ячеек, либо ячейки вообще могут не иметь адресов (такая память называется ассоциативной).

Все современные ЭВМ, которые имеют больше одного процессора, не выполняют команды последовательно. Команды могут выполняться одновременно, при этом принадлежать как одной программе, так и разным программам.

Лишь в $2015$ году впервые было сделано заявление о создании нового типа процессора (мем-процессора) с архитектурой принципиально отличной от фон-неймановской. Мем-процессор по утверждению разработчиков использует для вычислений и хранения полученных данных одно и тоже место, и потому не тратит энергию на обмен данными между процессором и памятью. Созданное устройство способно решить за десять миллионов итераций задачу, на которую обычный процессор тратит десять миллиардов итераций.

Принцип двоичного кодирования данных

Все сведения, которые предназначены для компьютерной обработки, такие как числа, тексты, аудиозаписи, графика и видеозаписи, в том числе и программы для её обработки, описываются в формате двоичного кода — последовательностей нулей и единиц.

Любой современный компьютер производит хранение и обработку данных в двоичном формате. Выбрана такая система счисления потому, что в таком формате легко проводить арифметические операции, осуществлять «согласованность» с булевой логикой, технически реализовывать двоичные элементы памяти.

Однако, применение стандартной двоичной системы счисления имеет определённые недостатки. Во-первых, в такой ситуации возникает проблема представления отрицательных чисел и нулевой избыточности. Решения этих проблем были найдены уже на стадии возникновения компьютерной техники.

В 1958-м году в Московском государственном университете имени М. В. Ломоносова под руководством Н. П. Брусенцова был спроектирован троичный компьютер «Сетунь». При его разработке применяли улучшенную троичную систему счисления. Это позволило впервые с лёгкостью представлять и положительные, и отрицательные числа.

В результате благодаря двоичному кодированию, информация и программы становятся схожими по формату представления, потому доступными для хранения в единой памяти.

Архитектура IBM

Архитектура персонального компьютера, спроектированная фирмой IBM, по сути являет собой мировой стандарт. Главная её отличительная особенность — это открытая структура. Другими словами, персональные компьютеры, в соответствии с этим стандартом, перестали быть окончательными завершенными брендовыми продуктами.

IBM — это фирма, которая является одной из первых на рынке производства компьютеров, кто выработал общепризнанную архитектуру.

Но она не монополист при этом, то есть фирмы и компании, производящие компьютеры и их составляющие элементы, сами определяют состав сборки персональных компьютеров. В то же время, всегда остается возможным осовременить свой персональный компьютер, заменив комплектующие на более продвинутые. Реализация технологии открытой архитектуры современных компьютеров стала возможной благодаря быстрым темпам прогресса.

Принципы открытой архитектуры: как персональные компьютеры стали массовым явлением

Расцветом эпохи компьютеростроения считается переход от производства больших электронно-вычислительных машин к развитию сегмента микрокомпьютеров, или, как принято их сейчас называть, ПК. Ассортиментом современных «персоналок» пользователи во многом обязаны компании IBM и принципам открытой архитектуры, которыми руководствовались ее разработчики при создании культового IBM PC. Домашние компьютеры, какими их привыкли видеть теперь, унаследовали эту концепцию и обрели мировую популярность, перестав быть достоянием энтузиастов в сфере электроники и программирования. Так в чем заключается принцип открытой архитектуры?

Предпосылки: архитектурная открытость ЭВМ

Период 60-70-х годов в мире вычислительной техники ознаменовался возникновением электронно-вычислительных машин третьей волны. Тогда индустрия впервые перешла от создания единичных моделей ЭВМ к наладке серийного производства. Безусловным лидером на рынке считалась корпорация International Business Machines. Представленная ею в 1964 году серия мейнфреймов System/360 стала поистине революционным решением. В нее вошли 6 универсальных компьютеров, отличающихся по стоимости и мощности. Главное отличие от ряда конкурирующих экземпляров – взаимная совместимость. Программы или устройства ввода-вывода одного компьютера запускались и на других продуктах серии.

Раньше подход к созданию продукции отличался: каждая модель разрабатывалась с нуля – со своим процессором, написанными под него программами и конкретным пакетом периферийных устройств. Это затрудняло обмен данными между машинами разных моделей и влекло затраты, связанные с несовместимостью. Концепция, предложенная IBM, призывала утвердить некий стандарт и сократить расходы на обслуживание малосовместимых ЭВМ. Позднее такая унификация привела к созданию комплементарных модулей, выпускаемых другими фирмами.

До этого пользователи ограничивались стандартными конфигурациями вычислительной техники. Впоследствии же ее модифицировали согласно личным нуждам для решения большего количества задач, нежели заложено заводскими предустановками. Модульность и техническая совместимость стали основой принципа открытой архитектуры компьютера.

Первый микрокомпьютер на открытой архитектуре

У любителей-радиоэлектронщиков ЭВМ вызывали досаду: стоили дорого, использовались только организациями, а люди, обслуживавшие такие машины, считались избранными. Это привело к тому, что в среде энтузиастов предпринимались попытки «спаять» собственный компьютер. Но владения практическими навыками в сборке было недостаточно. Требовались по меньшей мере базовые знания программных языков, чтобы «завести» собранную машину.

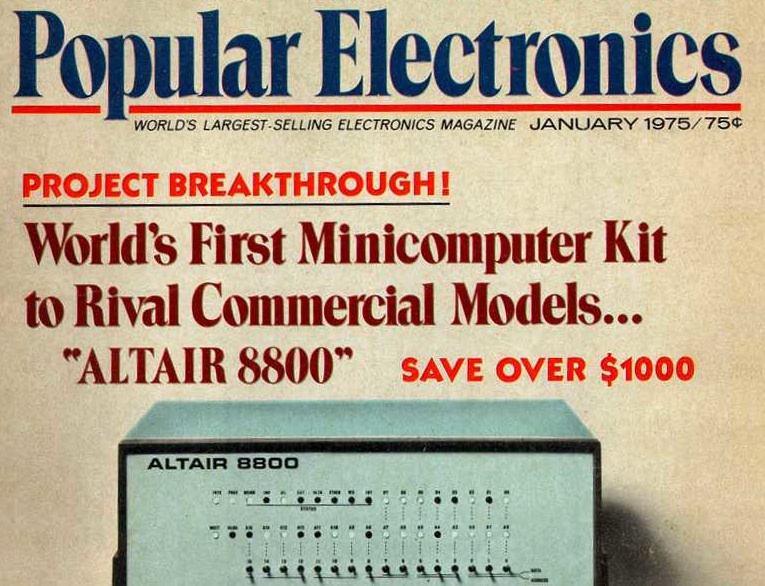

Ключевым поворотом в истории, давшим импульс эпохе персональных ЭВМ, стала разработка микрокомпьютера Altair-8800 компанией MITS в 1974 году. Модель представляла собой набор печатных плат, заключенный в пластиковую коробку с переключателями и лампочками. Не было ни монитора, ни клавиатуры, столь привычных в нынешнем понимании. Но для общественности эта модель представляла немалый интерес, поскольку продавалась как в собранном виде, так и в комплектах деталей. Такой конструктор сопровождался инструкцией и техпаспортом. Политика производителя по разглашению этой информации и предоставлению возможности самостоятельной сборки воплощала принцип открытой архитектуры компьютера. Что было дальше?

IBM PC как стандарт принципов открытой архитектуры

Спустя шесть лет после дебюта «Альтаира» мир увидел IBM PC, ставший заключительным этапом в формировании понятия «персональный компьютер». Видя, как рынок микрокомпьютеров стремительно заполняют конкуренты вроде Apple и Commodore, руководство IBM решило не упускать шанс и спроектировать собственную персоналку.

Прежде компания производила необходимые комплектующие, не прибегая к помощи третьих лиц. Однако на этот раз времени на разработку не хватало – IBM рисковала опоздать и не запрыгнуть в уходящий поезд. Поэтому корпорация назначила команду, отвечавшую за поиск новых высокопроизводительных деталей, которые только предлагал рынок микроэлектроники того времени. Так, за процессором обратились к Intel, операционную систему предложила еще только развивающаяся фирма Microsoft, принтер взят у Epson, а монитор – у IBM Japan. Корпоративными усилиями создана только клавиатура и конечная комплектация.

В модель изначально закладывалась идея апгрейда. Конкурентную продукцию в большинстве представляли статичные машины, подверженные неизменному устареванию. Тогда как этот PC предусматривал наращивание производительности. Кроме того, наработки оказались доступными для желающих, что дало сторонним фирмам право на изготовление системных и периферийных устройств без необходимости покупки лицензии.

Стандартизация комплектующих, открытое лицензирование и свободное замещение деталей раскрыли суть принципа открытой архитектуры, породив настоящий бум персональных компьютеров. С тех пор аббревиатура ПК ассоциировалась с IBM-PC-совместимыми микрокомпьютерами. В похожем контексте этот термин употребляется по сей день.

Наше время

Ассортимент персональных компьютеров представлен преимущественно ПК с открытой архитектурой. Их владельцы вправе собственноручно модифицировать программную и аппаратную часть. К числу популярных марок относят:

- Acer;

- ASUS;

- Dell;

- Hewlett-Packard;

- Lenovo.

Компьютеры Apple, напротив, представляют закрытый тип архитектуры. Компания сама создает компоненты и ПО, так что улучшить Mac рядовому юзеру не представляется возможным. Наряду с завышенной стоимостью это считается недостатком, который, впрочем, компенсируется гарантией качества продукции. Архитектурная открытость хоть и предполагает наличие некоторых уязвимостей, но не представляет угрозы при грамотной эксплуатации. Взамен же владелец получает простор для модификаций и волен персонализировать ПК, опираясь на личные цели и предпочтения.

Подсчет в двоичном формате

В двоичном выражении первая цифра равноценна 1 из десятичной системы. Вторая цифра равна 2, третья – 4, четвертая – 8, и так далее – удваивается каждый раз. Добавление всех этих значений даст вам число в десятичном формате.

1111 (в двоичном формате) = 8 + 4 + 2 + 1 = 15 (в десятичной системе)

Учет 0 даёт нам 16 возможных значений для четырех двоичных битов. Переместитесь на 8 бит, и вы получите 256 возможных значений. Это занимает намного больше места для представления, поскольку четыре цифры в десятичной форме дают нам 10000 возможных значений. Конечно, бинарный код занимает больше места, но компьютеры понимают двоичные файлы намного лучше, чем десятичную систему. И для некоторых вещей, таких как логическая обработка, двоичный код лучше десятичного.

Следует сказать, что существует ещё одна базовая система, которая используется в программировании: шестнадцатеричная. Хотя компьютеры не работают в шестнадцатеричном формате, программисты используют её для представления двоичных адресов в удобочитаемом формате при написании кода. Это связано с тем, что две цифры шестнадцатеричного числа могут представлять собой целый байт, то есть заменяют восемь цифр в двоичном формате. Шестнадцатеричная система использует цифры 0-9, а также буквы от A до F, чтобы получить дополнительные шесть цифр.

Компьютерное поколение

После Второй Мировой Войны началась главная «ступень» развития IT. Наступило мирное время, когда люди смогли изучить интегральные схемы, а также производить различные механизмы без спешки. В этот период в свет вышли несколько компьютерных поколений.

Первая ступень

История развития вычислительной техники современного типа началась с ламповых компьютеров. Основаны они на архитектуре фон Неймана. Малая экспериментальная машина создана в Манчестерском университете в 1948.

В «мирном режиме» ученые произвели:

Это – «Евы» современной архитектуры ПК. В Европе к первому поколению относят Z4, в СССР – МЭСМ.

Серийный выпуск компьютеров в Советском Союзе начался с 1953 – с ЭВМ «Стрела». В 1954 IBM представила IBM 360, которая быстро набрала популярность. Этот «модельный ряд» выпускался в 2 000 экземплярах.

В 1955 появилось понятие микропрограммирования. В 1956 IBM продает устройство для хранения – магнитные ленты, основанные на дисках – RAMAC. Устройство могло хранить до 5 МБ данных.

Второе поколение

Началось с изобретения транзистора. IBM представили IBM 650 на лампах. Но размер устройства достигал письменного стола. Доступны такие устройства были только для работы крупных организаций из-за своей стоимости.

Далее популярностью пользовались следующие «девайсы»:

- IBM 7090;

- IBM 1401 – задействовала перфокарточный ввод;

- IBM 1620 – на перфолентах, позже – на перфокартах;

- PDP-1 от DEC в 1960;

- B5000 от Burroughs Corporation со стековой архитектурой и дескрипторами;

- Atlas – с виртуальной памятью на основе подкачке страниц и конвейерным выполнением инструкций.

В этот же период началось развитие языков программирования высокого уровня. Они помогали прямо задавать цели ПО и применяются по сей день.

Третье поколение

Начало – в 1960. Это – период бурного роста ПК. Началось все с изобретения интегральной схемы. В 1964 мир увидел мейнфрейм IBM/360. Аналогом в СССР послужили устройства типа ЕС ЭВМ.

Вместе с третьим поколением выпускалось второе. Это происходило до 1970.

Четвертое поколение

Информация уже передавалась через шину данных с достойной тактовой частотой. В 1970-е появилось 4 поколение компьютерных устройств. Началось все с создания центрального процессора на одном кристалле. Так появились микропроцессоры от Intel.

Стив Возняк, работающий в Apple, придумал первый домашний ПК. Он получил массовое производство.

Пятое поколение

Датируется 1992 годом. Можно назвать это «современным движением». Техника для вычисления была основана на сверхсложных микропроцессорах, включающих в себя параллельно-векторную структуру. Она подходит для выполнения огромного количества команд одновременно. Технику такого типа, предназначенную для широкого применения, задействуют для быстрой и точной обработки данных, создания эффективно функционирующих сетей.

Шестое поколение

Сейчас все еще актуально развитие вычислительных техник. Но теперь набора элементарных математических функций для удовлетворения потребностей населения мало.

Шестое поколение ЭВМ началось примерно с 2013. Представлены оптоэлектронными и электронными устройствами. Включают в себя тысячи микропроцессоров. Они обладают массовым параллелизмом, а также моделирующей архитектурой нейронных биологических систем.

Этапы становления истории ЭВМ, состоящей как из больших шагов, так и мелких открытий, позволили подойти к внедрению искусственного интеллекта. Сейчас можно сделать вывод о том, что IT-сфера стремительно развивается. Она начинает использовать биоданные и совершенные технологии программирования, чтобы облегчать жизнь компаниям и рядовым гражданам.

История развития вычислительной техники в наши времена привела к созданию практически совершенных цифровых машин. И пока неизвестно, что будет дальше. Но разработчики стараются производить «девайсы», которые требовали бы минимального вмешательства человека в процесс работы.

P. S. Интересуют компьютеры и сфера информационных технологий? Обратите внимание на профессиональные курсы Otus!