Общие ресурсы Block (iSCSI) в FreeNAS 11

iSCSI является стандартом протокола для консолидации данных хранилища. iSCSI позволяет FreeNAS действовать как сеть хранения данных (SAN) по существующей сети Ethernet.

В частности, он экспортирует дисковые устройства через сеть Ethernet, к которым могут подключаться и монтировать клиенты iSCSI (называемые инициаторами).

Традиционные сети SAN работают по сетям волоконно-оптических каналов, для которых требуется инфраструктура волоконно-оптических каналов, таких как HBA волоконного канала, коммутаторы волоконных каналов и дискретные кабели.

iSCSI может использоваться по существующей сети Ethernet, хотя выделенные сети могут быть созданы для трафика iSCSI в целях повышения производительности. iSCSI также обеспечивает преимущество в среде, которая использует программы оболочки Windows; эти программы имеют тенденцию фильтровать Network Location (Сетевое расположение), но iSCSI mounts не фильтруются.

Совместное использование сетевого диска iscsi

Сервер

fdisk -l проверить количество дисков, если диск только один, вы можете добавить диск самостоятельно

Создать новый диск

Синхронизировать и создать новый диск

Загрузить плагин

yum install targetcli -y скачать плагин

targetcli войти на страницу редактирования

Если другие хотят получить к вам доступ, брандмауэр должен пройти, поэтому пусть порт общего диска позволит брандмауэру проходить через

Порт 3260

Клиент:

1. Установите клиентское программное обеспечение iscsi.

yum install iscsi-initiator-utils.x86_64 -y скачать плагин

2. Отредактируйте файл конфигурации.

vim /etc/iscsi/initiatorname.iscsi отредактируйте и прочтите файл

Перезапустите службу systemctl restart iscsi

3. Найден новый диск

-m означает режим, путь

-t означает тип (sendtargets отправляет цель)

-p означает порт

4. Можно использовать общий диск

5. Убедитесь, что к нему поделились

6. Отформатируйте диск, чтобы система его распознала.

7. Крепление

Преимущества iSCSI

- IP-протокол и промежуточное ПО (middleware) для управления, безопасности и качества сервиса QoS (quality of service) могут быть использованы в сетях SAN.

- Компетенции и опыт пользователя в IP-сетях LAN (local-area network) могут быть применены к сетям SAN на базе IP.

- За счет использования стандартной IP-инфраструктуры, продуктов и сервисов может быть получена значительная экономия при создании сетей хранения SAN, основным недостатком которых являлась сложность проектирования, недостаточная совместимость и дороговизна развертывания, в то время как iSCSI может существенно сократить эти затраты.

- Гигабитные Ethernet коммутаторы могут повысить быстродействие SAN, уменьшить число ошибок, могут контролировать параметры потоков. Таким образом, можно обеспечить оптимальные скорости передачи через локальные сети LAN, глобальные WAN, и городские MAN (metropolitan-area networks).

- iSCSI совместим с существующей инфраструктурой Ethernet и IP WAN, а также с множеством других существующих и будущих IP-протоколов.

- Единая транспортная технология для сетей хранения, серверов и клиентов в сетях LAN, WAN, SAN.

- Возможность географического распределения систем хранения

- Возможность использовать средства управления TCP/IP сетями.

iSCSI может обеспечить хорошие параметры работы блочного хранилища при низких затратах. Этот протокол поддерживается большинством операционных систем и гипервизоров и может работать через стандартные сетевые адаптеры или через специализированные адаптеры HBA (Host Bus Adapters). Кроме того, iSCSI поддерживается большинством корпоративных СХД, где работают приложения второго уровня (Tier 2), которые требуют хорошего, но не превосходного качества работы блочных СХД, а также в СХД, которые используют много хостов одновременно.

iSCSI также популярен среди крупных облачных провайдеров, там часто используются блочные хранилища, которые работают поверх Ethernet.

Стек протоколов iSCSI

Alex18

Neophyte

Тогда меня несколько смущают сообщения на сервере (FreeBSD) вида:

С конфигурацией /etc/ctl.conf:

которую пробуют подключить два линукса через:

iscsiadm -m discovery -t st -p 10.55.57.193

iscsiadm -m node —login

где 10.55.57.193 — IP сервера.

При этом клиенты также рвут соединения постоянно (и восстанавливают):

С виду — активно в один момент времени только на одном.

Я правильно понимаю, что FreeNAS в плане iSCSI имплементации аналогичен FreeBSD или есть дополнительные совершенствования?

PS: провел эксперемент, когда и таргет и инитиаторы — это FreeBSD, и там такое поведение не вижу ( iscsictl -A -p 10.55.57.193 -t iqn.:target0 + iscsictl показывает все ровно + нет session reinstatement при одновременным обращениям к /dev/da* ). Однако, в моем случае, компания планирует использовать FreeNAS как iSCSI target, но клиенты увы, будут выступать Linux, тк нужно использовать GFS2 ( GFS2 на фре вроде совсем отсутствует ).

Создание отказоустойчивого кластера

На данном этапе можно создать кластер, начиная с любого узла кластера. Я организовал кластер, начав на первом узле (WS2012-N1).

Чтобы создать новый кластер, выберите ссылку Create Cluster на панели Management или панели Actions, как показано на экране 5.

.jpg) |

| Экран 5. Запуск мастера создания кластера |

В результате будет запущен мастер создания кластера, работа которого начинается со страницы приветствия. Нажмите кнопку Next, чтобы перейти на страницу выбора серверов, показанную на экране 6. На этой странице введите имена всех узлов кластера, затем нажмите кнопку Next.

.jpg) |

| Экран 6. Выбор серверов для кластера |

На странице Access Point for Administering the Cluster следует указать имя и IP-адрес кластера, которые должны быть уникальными в сети. На экране 7 видно, что имя моего кластера WS2012-CL01, а IP-адрес — 192.168.100.200. При использовании Server 2012 IP-адрес кластера может быть назначен через DHCP, но я предпочитаю для своих серверов статически назначаемый IP-адрес.

.jpg) |

| Экран 7. Настройка точки доступа кластера |

После ввода имени и IP-адреса нажмите кнопку Next, чтобы увидеть страницу подтверждения (экран 8). На этой странице можно проверить настройки, сделанные при создании кластера. При необходимости можно вернуться и внести изменения.

.jpg) |

| Экран 8. Подтверждение параметров, выбранных при создании кластера |

После нажатия кнопки Next на странице подтверждения формируется кластер на всех выбранных узлах. На странице хода выполнения показаны шаги мастера в процессе создания нового кластера. По завершении мастер покажет страницу сводки с настройками нового кластера.

Мастер создания кластера автоматически выбирает хранилище для кворума, но часто он выбирает не тот диск кворума, который хотелось бы администратору. Чтобы проверить, какой диск используется для кворума, откройте диспетчер отказоустойчивого кластера и разверните кластер. Затем откройте узел Storage и щелкните узел Disks. Диски, доступные в кластере, будут показаны на панели Disks. Диск, выбранный мастером для кворума кластера, будет указан в разделе Disk Witness in Quorum.

В данном примере для кворума был использован Cluster Disk 4. Его размер 520 Мбайт, чуть больше минимального значения для кворума 512 Мбайт. Если нужно использовать другой диск для кворума кластера, можно изменить настройки кластера, щелкнув правой кнопкой мыши имя кластера в диспетчере отказоустойчивого кластера, выбрав пункт More Actions и Configure Cluster Quorum Settings. В результате появится мастер выбора конфигурации кворума, с помощью которого можно изменить параметры кворума кластера.

Подключение

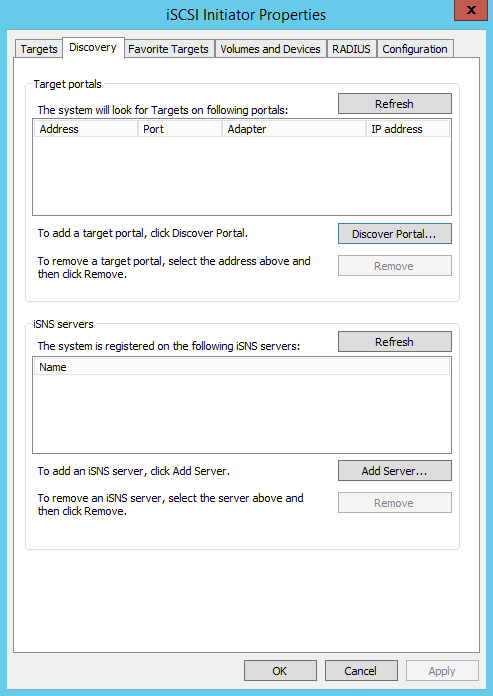

Возвращаемся на SRV2, открываем окно свойств инициатора, переходим на вкладку Discovery и жмем кнопку Discover Portal.

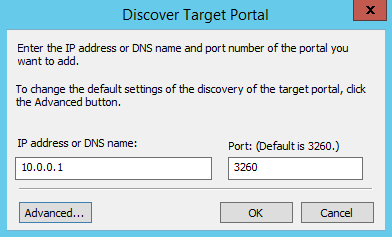

Вводим имя или IP-адрес портала и жмем ОК.

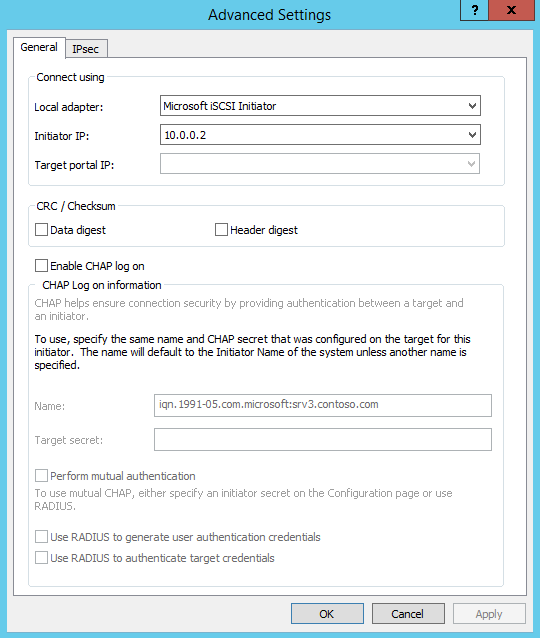

По умолчанию iSCSI использует все доступные IP-адреса, и если вы хотите, чтобы трафик iSCSI шел только через определенный сетевой интерфейс, то надо перейти в расширенные настройки и в поле «Connect using» указать нужный IP.

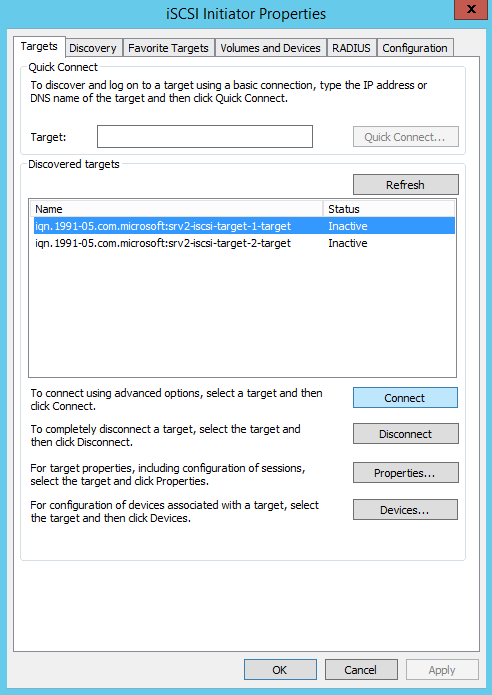

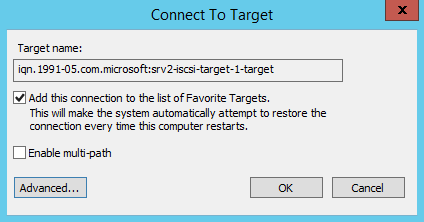

Теперь переходим на вкладку Targets, где должны отобразиться все доступные для подключения iSCSI Target. Выбираем нужный таргет и жмем «Connect».

Не забудьте отметить чекбокс «Add this connection to the list of Favorite Targets», который обеспечивает автоматическое подключение к таргету при выключении или перезагрузке машины.

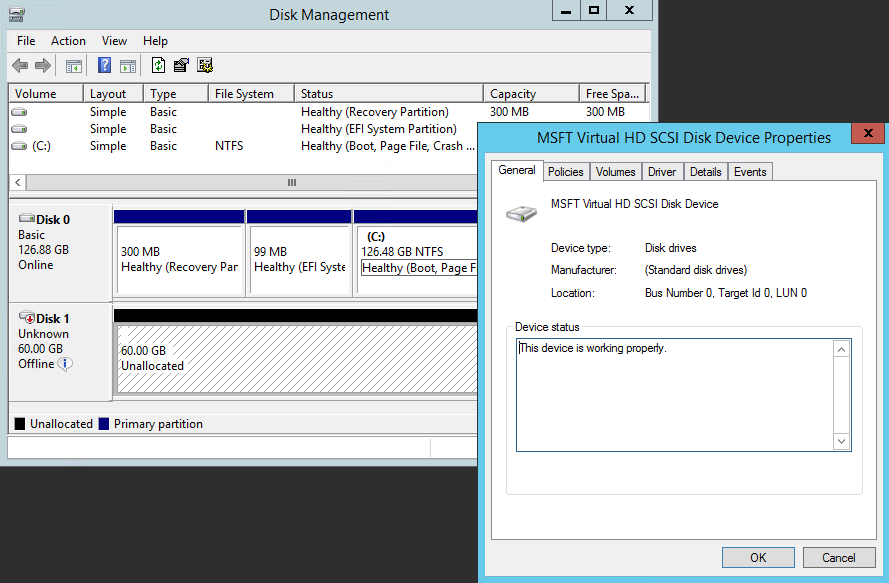

Подключение состоялось, и если открыть оснастку управления дисками, то там появится новый диск. Дальше с этим диском поступаем так же, как с обычным жестким диском, подключенным локально — переводим в Online, инициализируем, создаем на нем разделы и форматируем.

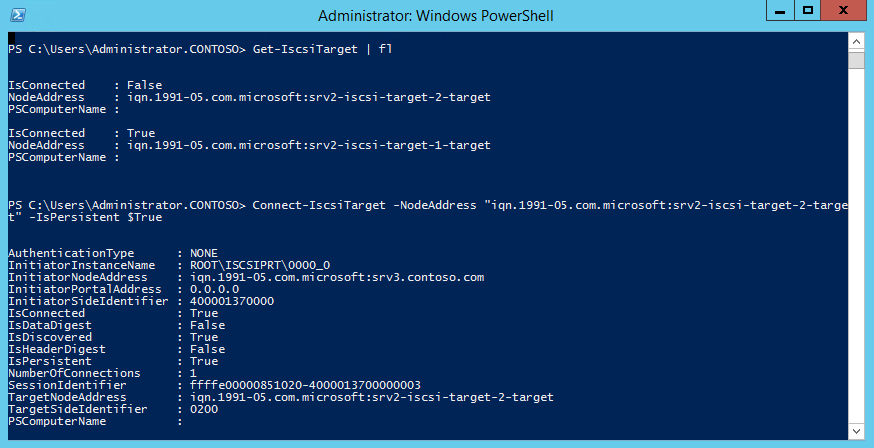

То же самое можно выполнить с помощью PowerShell. Выводим список доступных таргетов:

И подключаемся к нужному:

Connect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -IsPersistent $true

Ключ -IsPersistent $true обеспечивает автоматическое подключение при выключении или перезагрузке.

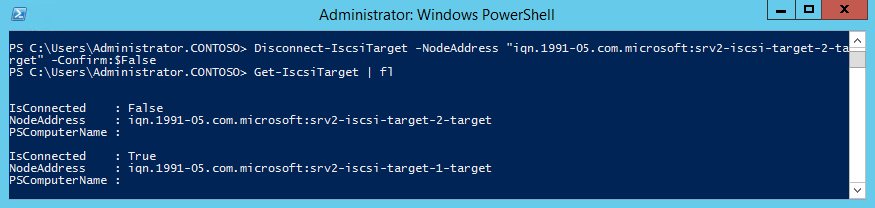

Ну и для отключения можно воспользоваться командой Disconnect-IscsiTarge, вот так:

Disconnect-IscsiTarget -NodeAddress ″iqn.1995-05.com.microsoft:srv2-iscsi-target-2-target″ -Confirm:$false

Комментарии (3)

Гость Алекс

Очень жду эту фитчу! Честно из-за ее отсутствия я откатился на 10ку, хотя в 11 много чего нравится,

Grey3

Цитата: Гость Виталий России нужен отечественный VPN. Пользуйтесь Kaspersky VPN — ежемесячно

Гость Алексей

При попытке открыть получившийся ISO в пустой виртуалке, пишет «Fatal: Could not read from the boot

rediffusion

Цитата: pawel97 http://wimlib.net Это что под macOS?

rediffusion

Как будут выглядеть параметры, если ссылаться на уже извлечённый install.wim из .ISO?

Как построить iSCSI SAN?

iSCSI SAN подходит для малых и средних предприятий, у которых есть большие объемы данных для хранения и передачи по сети. Вот несколько советов о том, как установить и настроить iSCSI SAN для корпоративной сети:

Во-первых, хотя сеть хранения iSCSI может работать в существующей сетевой инфраструктуре, лучше разместить трафик iSCSI в его собственной VLAN, предпочтительно в полностью отдельной гигабитной сети. Это помогает создать резервное соединение для хранения данных в случае сбоя сети.

Во-вторых, для iSCSI SAN лучше использовать неблокирующий коммутатор Gigabit Ethernet корпоративного класса. Коммутатор потребительского уровня часто не поддерживает соединения между несколькими портами на скорости проводной сети, поэтому они могут отбрасывать пакеты без предупреждения. Для приложений центров обработки данных 10GbE iSCSI SAN более ориентирован на будущее, поэтому предпочтительнее использовать коммутатор 10GbE.

Наконец, если ваши серверы имеют одногигабитные подключения к коммутатору Ethernet для доступа к дисковым массивам, они уязвимы для сбоя на этом канале. Лучше всего использовать технику многопутевого ввода-вывода (MPIO) для создания нескольких подключений от инициатора iSCSI каждого сервера к вашему дисковому массиву.