Можно ли поставить две разные видеокарты на компьютер

Многих пользователей часто волнует вопрос, как установить две видеокарты на один компьютер? Причём, неважно, будет ли это карты NVidia или AMD. Необходимость подобной операции чаще всего заключается в увеличении быстродействия компьютера, в частности его видеосистемы.

Поскольку видеоадаптеры, по сути, являются математическими процессорами, работающими с большим количеством операций с плавающей точкой, для центрального процессора нет никакой разницы, куда ему отправлять данные для обработки – в одно внешнее устройство или в два. Теоретически, таких устройств может быть сколько угодно (их число ограничено лишь количеством слотов расширения PCIE, в которых могут устанавливаться видеоадаптеры). То есть, две видеокарты в одном компьютере – это ещё не предел.

При таком подключении даже типы карт (а при правильном подходе к вопросу, даже их производители) могут быть не одинаковые. Главное, чтобы с программной точки зрения они были совместимы. Но, поскольку «общение» программы с «железом» карты осуществляется через стандартизованные библиотеки функций (DirectX, OpenGl и т.д.), то фактически нет никаких ограничений для использования нескольких видеоустройств в одной системе.

Требования к системе с двумя видеокартами

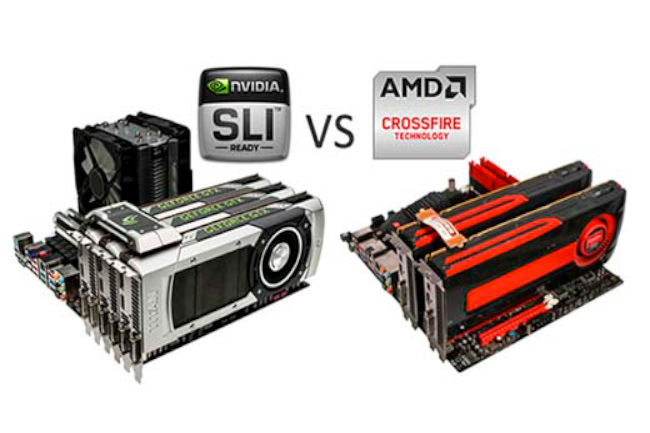

Чтобы использовать две видеокарты, вам необходимо базовое оборудование, AMD или Nvidia для запуска их графических технологий. Графическое решение AMD — фирменный CrossFire, а решение Nvidia — SLI. Есть способы использовать два разных бренда вместе. Для каждого из этих решений вам нужна совместимая материнская плата с необходимыми графическими слотами PCI Express. Без одной из этих слотов в материнской плате, использование технологии двух карт невозможно.

Что для этого нужно?

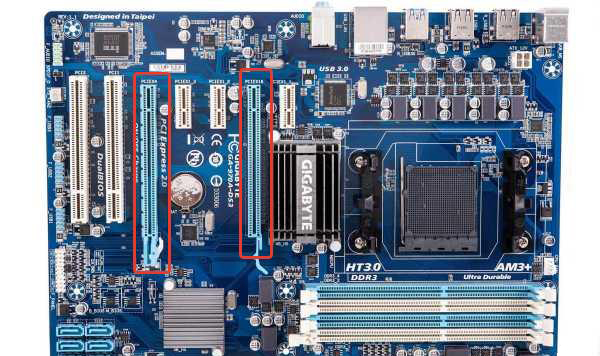

- Для начала, нам нужна материнская плата с несколькими слотами для установки видеокарт. Выглядит это так.

Материнская плата с несколькими слотами для установки двух видеокарт

Важно! Обязательно уточняйте в документации или на сайте производителя платы, какой стандарт подключения пары видеокарт она поддерживает. Если собираетесь ставить две видеокарты nVidia, то нужен стандарт под название SLI, если AMD Radeon — то стандарт CrossFire.

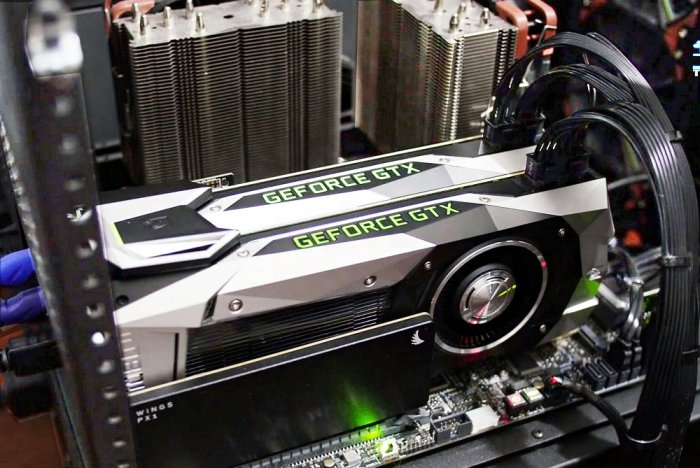

Обе видеокарты должны быть одинаковыми или близкими по серии

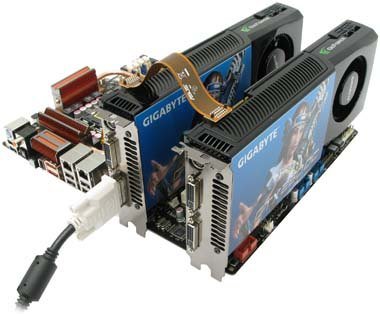

Для каждого стандарта видеокарт свои контактные шлейфы для соединения плат

Примечание! Покупать одинаковые видеокарты и соединительный шлейф нужно только в том случае, если вы собираетесь объединять их для получения большей мощности. Если ваша цель — подключить больше мониторов, то видеокарты могут не совпадать, а шлейф не нужен вовсе.

При работе двух видеокарт нужен мощный блок питания

При работе двух мощных видеокарт нужен мощный корпус, чтобы избежать перегрева

Почему установка двух видеокарт в компьютер в связке SLI или CrossFireX в большинстве случаев не имеет смысла. Или почему производители видеокарт никогда не доведут технологии SLI и CrossFireX до ума!

Здравствуйте, вопрос! Купил две видеокарты GeForce GTX 1070 по 38 тысяч каждая и установил их в свой компьютер в связке SLI, но результаты в тестах в Futuremark 3DMark показывают, что производительность (по сравнению с одной видеокартой) увеличилась всего на 10-15%, а я ждал хотя бы 50%. Также в современных играх две видюхи не повысили мне FPS, а в некоторых (в частности FAR CRY PRIMAL) даже понизили. Получается, что лучше бы я за эти деньги купил не две, а одну видеокарту GeForce GTX 1080 или даже GeForce GTX 1080 Ti. А так я выкинул деньги на ветер. Не повторяйте пожалуйста моей ошибки. И ещё, мало кто знает, что видеокарты NVIDIA десятой серии не все могут работать в режиме моста (SLI), например GeForce GTX 1050 и GTX 1060 не могут, также GTX 1070 нельзя поставить в связку с GTX 1080 . Расскажите пожалуйста об этом на своём сайте.

Всем привет! Почти все пользователи, которые любят порубиться в различные игрушки, наверняка задумывались или слышали про то, что в систему можно ставить две и более видеокарты для объединения их мощности. Собственно технология объединения двух и более графических процессоров для обработки трехмерного изображения представленная компанией Nvidia называется SLI (scalable link interface, рус. масштабируемый интерфейс связи). Аналог от компании AMD называется CrossFireX. В чём плюсы и минусы каждой технологии, стоит ли пользоваться этими технологиями, как они работают Об этом я сегодня и расскажу.

- И главное, я расскажу почему производителям видеокарт невыгодно, чтобы технологии SLI или CrossFireX увеличивали производительность работы графической системы компьютера на 100%.

Итак, начнем с зеленых ( Nvidia) . Для того, чтобы поставить себе в систему SLI связку вам понадобятся 2+ видеокарты одной серии и одной модели. В отличие от красных ( AMD) (о которых мы поговорим чуть позже), графические процессоры более привередливые в этом плане. Если более старшие линейки карточек позволяли объединять в мост абсолютно любые модели (главное чтобы они были одинаковые), то в последней десятой линейке все изменилось. Построить мост вы сможете только из GTX 1070, 1080 и 1080Ti. С чем это связано лично для меня остается загадкой, но, к сожалению, сейчас только эти модели можно объединять. По поводу титанов не могу дать никакой информации.

Что же касается красных, то у них есть как преимущества перед зелеными, так и недостатки. Главный плюс состоит в том, что можно объединять абсолютно любые модели, главное условие – чтобы объединяемые видеокарточки были построены на одинаковой архитектуре. К примеру, поставить в связку RX 460 и RX 470 компания AMD позволяет. А вот поставить GTX 1070 и GTX 1080 в связку уже не получится. Ну а главный минус CrossFireX это прирост производительности. Прирост мощности при использовании прямых карточек-конкурентов у красных значительно ниже, чем у зеленых. Да и оптимизация в большинстве игр поддерживающих связки видеокарт значительно хуже у компании AMD. Да, не все игры поддерживают SLI и CrossFireX. Что же касается вторичного производителя видеокарт, то он не имеет абсолютно никакого значения. То есть если вы имеет две GTX 970, одна от MSI, а другая от Palit, то это никак не повлияет на результат. Это правило применимо как к видеокартам от Nvidia, так и картам от AMD.

1. Материнская плата с двумя и более разъемами PCI-express x16, поддерживающая данную технологию. Не все мамки, которые имеют два и более разъема под видеокарты поддерживают связку видеокарт! На самой материнке всегда есть соответствующая маркировка, на сайте производителя об этом написано, а так же всегда указано в прилагающейся инструкции. Помните, что если вы не нуждаетесь в мамке, которая поддерживает SLI и CrossFireX, то выбирайте соответствующую плату, так как вы всегда переплачиваете деньги за то, что мамка оснащена поддержкой связи видеокарт.

4. Мост, объединяющий видеокарты. Насколько мне известно, AMD позволяет объединять карты и без использования данного моста, то есть с помощью программного обеспечения. Однако в таком случае потери в производительности составят около 15-20,% нежели в случае если бы вы использовали мост.

На мой взгляд, строить систему на основе данных технологий не стоит. А не стоит, потому что лучше купить одну более мощную видеокарту, нежели две, но послабее. К примеру, две GTX 1070 будут слабее, чем одна GTX 1080. А все потому, что данные технологии имеют очень плохую оптимизацию под игры и другие ресурсоёмкие приложение, у зеленых она конечно лучше, чем у красных, но всё равно плохая. Прирост производительности, как вы могли подумать, не будет составлять 100% от использования второго графического процессора. В лучшем случае он будет составлять 40-50%. И то, в подавляющем большинстве он будет равняться 15-25%. То есть вопрос целесообразности такой покупки остается открытым с точки зрения цена/производительность. Ставить себе такую систему имеет смысл только в том случае если мощности самой топовой на данный момент видеокарты вам недостаточно. А такое случается только в очень узкоспециализированных случаях. Например, для достижения стабильного количества кадров в секунду на 144гц мониторе в очень тяжелых играх. В легких играх топовая 1080Ti спокойно справляется с данной задачей. Либо если вы хотите играть в высоком разрешении – 4 или 8к.

Так же не стоит забывать и про видеопамять. В случае если вы объединяете две видеокарты с разным количеством памяти, то используется только та память, которая по размеру меньшая. К примеру, вы поставили RX 480 с 4gb и RX48 c 8 gb. Как вы могли подумать, вам будет доступно 12 гигабайт видеопамяти. К сожалению это не так. Будет доступно только 4 гига. Если же вы имеете две одинаковые видеокарты, но работающие на разных частотах, то в таком случае они обе также будут работать на младшей частоте. То есть, к примеру, одна работает на 1544гц, другая на 1622гц, обе будут работать на 1544гц. В будущем, с полным переходом на DirectX 12 нам обещают полную оптимизацию и полное использование всех ресурсов объединяемых видеокарт. То есть будет 100% прирост мощности и полное суммирование имеющейся видеопамяти. Но это всё обещание, на деле же мы имеет то, что имеем. Безусловно, есть и такие интересные игровые проекты, где мы можем получить и 70%, и 80% прироста производительности, но таких, к сожалению, очень мало и они скорее исключение из правил. Как я люблю повторять, решать, в конечном счете, только вам, а я для себя уже давно решил, что на данный момент SLI и CrossFireX являются крайне нецелесообразными!

Можно ли установить две видеокарты?

Две видеокарты в один компьютер установить можно, но только в случае если на материнской плате есть нужное количество слотов PCI-E 16x.

Больше одной видеокарты в компьютер устанавливается для:

1. Подключения большего количества мониторов, чем поддерживает первая видеокарта. В таком случае модель второй видеокарты не важна, однако рекомендуем использовать видеокарты собранные на чипе одного производителя, например две видеокарты GeForce или две видеокарты Radeon, так как в противном случае возможны конфликты драйверов.

2. Увеличения производительности. В таком случае видеокарты, установленные в компьютере, должны быть построены на одинаковых графических процессорах и иметь одинаковый объем памяти. Кроме того карты должны поддерживать технологии объединения (SLI для видеокарт GeForce и CrossFire для карт AMD). Поддержка соответствующих технологий должна быть и со стороны материнской платы.

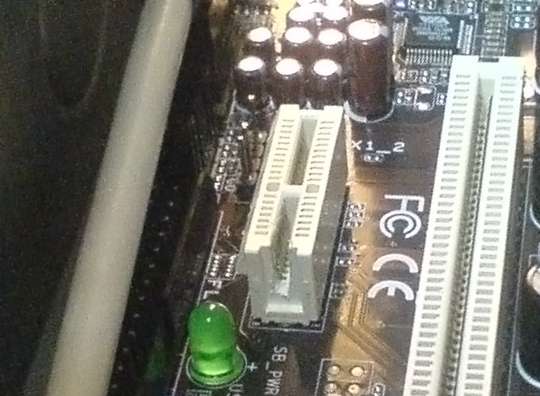

Ставим вторую видеокарту в разъём PCI-Express x1

Если в компьютере имеются 2 видеовыхода и захотелось подключить 3 монитора, то с некоторой вероятностью сделать это просто добавлением второй видеокарты не удастся — не все материнские платы имеют 2 разъёма PCI Express X16, а в многочисленные разъёмы PCI Express X1 видеокарты обычного размера не встанут из-за несовместимости по разъёму. Не все знают, что на самом деле установка длинного разъёма X16 в короткий слот возможна, поэтому не обязательно для 3-го монитора покупать другую и более дорогую материнскую плату. Способам расширения потенциальных возможностей компьютера посвящена эта статья, а также она развеивает сомнения и опасения о том, что что-то при доработке платы напильником не получится. Час работы — и 3-й монитор к Вашей системе будет подключен.

Проблема установки 2 видеокарт существует из-за того, что большинство слотов PCI-Express x1 имеют пластмассовый бортик на конце, дальнем от стенки корпуса компьютера, а видеокарты не имеют прорези для совместимости с бортиком. Как показывается ниже, проблема решается простым прорезанием этого бортика.

Для чего это может понадобиться?

1) Для установки 3-го монитора в систему.

Существуют, конечно, решения с 3-м монитором без хирургических операций с разъёмами.

1.1) Купить материнскую плату бюджетного типа с видеоразъёмом, установленным на плате. Внимание! Нужно быть уверенным, что BIOS платы не отключает автоматически встроенное видео, если видит установленную видеокарту. Для некоторых, особенно, бюджетных плат, такое решение встречается. Как убедиться в неотключении встроенного видео? Скорее всего, только опытом установки (видеокарты и 2 видеодрайверов), потому что в инструкциях к плате об этом могут не написать. (Например, я когда-то подключал для проверки 3 монитора к бюджетной плате Intel (на G31), но бюджетные платы Gigabyte с 2 слотами для ОЗУ имели функцию автоматического отключения встроенной графики.)

(рис.1)

1.2) Купить видеокарту с разъёмом PCI-Express x1. Таких видеокарт немного, но они есть. news.softportal.com/nitem-5729.html, www.oszone.net/print/9646, www.oszone.net/11230/Club3D_PCIe_x1_Radeon_HD_4350.

(рис. 2)

1.3) Купить материнскую плату с 2 или более разъёмами PCI-Express x16 (многие платы не нижней ценовой категории).

(рис. 3)

1.4) Отрезать лишний текстолит от видеокарты, как, например, здесь:

www.invisiblerobot.com/pcie_x1

(рис. 4)

(в какой-то степени шутка — зачем портить видеокарту, но здесь тоже так делали:

www.overclockers.ru/hardnews/22289.shtml )

1.5) Сильно не заморачиваться, а купить матплату, на которой стоит побольше PCI-Express x16-разъёмов:

(рис. 5)

(ещё большая шутка).

Все способы предполагают материальные затраты и более ограниченный выбор вариантов конфигурации. Если уже имеется плата со свободным слотом PCI-Express x1 и видеокарта с разъёмом PCI-Express x16, проще поступить так, как описано ниже.

Способ 1.6) Сделать прорезь на любом разъёме PCIe X1, удобном для установки видеокарты.

(рис. 6)

Спецификация требует включения линий питания и заземления карты расширения, даже если используется меньшее количество соединений. Поэтому, теоретически, после подключения мы можем получить проблемы из-за неполного подключения к питанию, но на практике их нет, потому что все линии питания на видеокарте просто объединяются в одну, а на маломощных видеокартах (не выше 3850) токи питания и частоты не настолько велики, чтобы это было критично. (Для решения проблемы есть адаптер uk.startech.com/product/PEX1TO16-PCI-Express-x1-to-Low-Profile-x16-Slot-Extension-Adapter, но он не понадобится.) По крайней мере, можно так надеяться, а более мощные видеокарты уже нет оснований так включать, потому что для них начинает сказываться ограниченная пропускная способность шины (в конце статьи — ссылка, дающая ответ на вопрос, видеокарту какой мощности разумно ставить в PCIe X1, а если в 2 словах, то ничего не теряем для видеокарт уровня GF8600GT/ATI 2600XT). Да и карта становится тяжёлой, что опасно для целостности такого небольшого разъёма.

UPD 2.10.2010 13:25 Читатели в комментариях напомнили ещё несколько способов подключения 3-го монитора, от известных древних до новых.

1.7) Купить видеокарту PCI. Так подключали мониторы во времена AGP и ранее. Такие карты существуют не только очень старые — есть инициативные производители, выпускающие их сейчас на современных чипах (обычно с фантастическими ценами):

www.3dnews.ru/news/audio_videokarta_asus_pod_shinu_pci_s_podderzhkoi_hdmi_1_3a

www.newegg.com/Product/Product.aspx?Item=N82E16814131082

www3.pny.com/8400-GS-512MB-PCI-Low-Profile-P2679C269.aspx

www.thg.ru/technews/20070820_110407.html

Исключение: как указал читатель Silent forest, нельзя добиться результата, если PCI-карта и PCI-Express-карта будет от одной и той же фирмы VNidia из-за банальной неподдержки драйвера для старой карты NVidia одновременно с новой (установка ATI PCI-Express разрешила конфликт).

1.8) Купить адаптер USB 2.0 to VGA (цены тоже довольно сильно кусаются, не менее 40$ — продукция ведь не массовая, выпускается некрупными партиями, с высокой долей себестоимости разработки):

www.nix.ru/autocatalog/adapters_switches/STLab_U470_USB_to_VGA_Adapter_88604.html

www.nextag.com/Startech-USB2VGAE2-USB-To-669150066/prices-html

(Наверное, есть проблемы с драйверами под немассовые операционные системы.)

1.9) Воспользоваться технологией ATI Eyefinity (для 3-го монитора требуется адаптер DisplayPort и видеокарта с поддержкой Eyefinity — Radeon 5xxx (чип RV870) и, разумеется, третий монитор с разъёмом DisplayPort) — для тех, кто хочет поддержать материально развитие инновационных технологий 🙂

www.amd.com/ru/products/technologies/eyefinity/Pages/eyefinity.aspx

www.nix.ru/computer_hardware_news/hardware_news_viewer.html?id=159707&page=10

2) Для подключения видеокарт в режиме Crossfire.

Строго говоря, для этого режима предусмотрены специальные материнские платы. Но, возможно, решение будет работать и с любой парой разъёмов PCIe (не проверялось).

Процесс доработки разъёма.

Перед работой убедитесь, что на материнской плате действительно будет свободное место для установки свободно висящего «хвоста» разъёма PCI-Express x16. Могут быть детали (конденсаторы, другие разъёмы), которые, в лучшем случае, удастся перепаять, разместив в другом положении.

Прорезание стенки достаточно просто, но требует соблюдения нескольких технических моментов в плане аккуратности операции.

1) материнскую плату лучше вынуть из корпуса, так как неосторожным движением можно повредить целостность разъёма или окружающих деталей;

2) прорезание выполнять так, чтобы не треснула пластмасса разъёма в основании. Поэтому, не использовать кусачки, резать острым скальпелем или лезвием для строительного ножа, соскабливая мелкими кусками или дремелем (машинкой для боров с установленной циркулярной пилой или наждачным диском), но осторожно, чтобы не повредить контакты. Нарушение целостности пластмассы тоже может привести к раздвиганию контактов, ненадёжному соединению.

3) срезая кусочки пластмассы острым ножом, следует быть очень осторожным, чтобы не срезать пружинящие контакты, которые находятся буквально в миллиметре от места операции. Если резать неострым ножом, на процедуру уходит времени 25-30 минут, а контакты, вероятнее, оказываются более защищены тем, что неострое лезвие их не перережет. На практике, у меня один контакт отогнулся вовнутрь, в пространство для текстолита карты, но затем его удалось подогнуть обратно.

4) пластмассу срезать до уровня дна разъёма; на фото показан процесс последовательного выскабливания стенки разъёма до нужной глубины:

(рис. 7)

5) перед установкой видеокарты внимательно проверить, что контакты не загнуты вовнутрь и видеокарта их не повредит.

6) при установке видеокарты — проверить, не прикоснётся ли оголённый разъём видеокарты проводящих поверхностей (радиаторы, детали). Если есть такая опасность, изолировать разъём или поверхности хотя бы скотчем или толстой бумагой, прикреплённой к карте.

(рис. 8)

7) После установки 2-й видеокарты — закрепить её за корпус, так как точка крепления за один маленький разъём PCIe довольно опасна для целостности самого разъёма.

На практике, я игнорировал рекомендацию (1), потому что места для работ внутри корпуса хватало и пользовался неострым б/у-лезвием. Стружки изнутри разъёма выдувал через трубку от шариковой ручки (использование офисных инструментов).

(рис. 9)

Столь незначительный набор инструментов (лезвие, трубка, возможно — скотч) и около часа времени на установку — небольшая плата за возможность подключения 3-го монитора. Может быть, он окажется лишним, но проверить удобство работы с ним и без него лишним не будет.

(рис. 10)

Пример процесса прорезания стенки разъёма, заснятый на видео, используя нагретое лезвие кухонного ножа: www.youtube.com/watch?v=gVBD-M_STsc (другой автор; на ютубе видео выложено 19.10.2009).

(рис. 11)

Такой способ тоже приведёт к результату, даже быстрее минут на 10, но «холодный» способ удобнее тем, что пластмасса не деформируется и не понадобится счищать наплывы, приводя к презентабельному виду.

Другой пример решения через удлинитель-переходник PCI Express x1 на PCI Express x16 — в статье автора SilentF people.overclockers.ru/SilentF/record4.

(UPD 2017-10: ссылка стала недоступной, но есть ещё одна — как сделать такой переходник самостоятельно, припаивая шлейф проводов)

(рис. 10a)

Здесь же решён вопрос, нерешение которого может привести к незапуску видеокарты: соединён контакт PRSNT #2 на конце разъёма PCIe x16 с таким же сигналом на разъёме PCIe x1. Он отвечает за определение «полноценной воткнутости» карты в слот: при неполностью вставленной карте определённый бит PRSNT (Piin-based Presence Detector) аппаратного регистра говорит «0» — «не вставлена». Если на видеокарте эти линии не замкнуты, без этой доработки регистр так и будет отмечать: «не вставлена», а что на основаниии него решит система — можем проверить. В любом случае, отсутствие сигнала не должно приводить к нестабильной работе: он влияет на этот аппаратный бит, а переход из 0 в 1 ещё создаёт аппаратное прерывание (hot plug карты расширения — «вставка во время работы»). Что оно делает в системе, заблокировано ли (по идее, должно, т.к. в компьютере PCIe — не «hot-plug» разъём) — тоже не известно, но опыт показывает, что без перемычки видеокарта 8300GS в PCIe x1 работает. (Если будет подозрение на некорректную работу вследствие PRSNT #2, можно сделать перемычку тонким проводом прямо на видеокарте.)

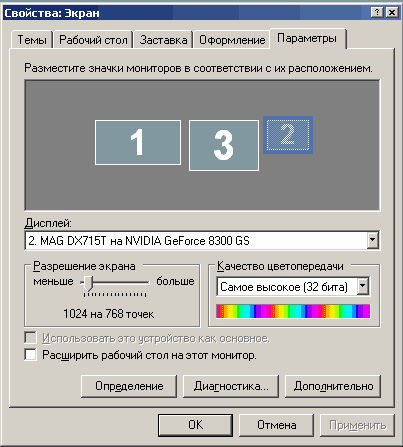

Установка 3-го монитора в системе (Windows XP)

При включении компьютера на вторую карту видеосигнал сначала не подаётся, дисплей сообщает о неподключённом кабеле. Операционная система без проблем обнаруживает видеокарту и подключает драйвер, если это карта того же производителя, что и первая, ранее установленная. WinXP просит перезапустить себя после автоустановки драйвера без каких-либо специальных действий для этого. После перезапуска система стала видеть монитор на второй видеокарте, а монитор обнаружил подключение кабеля.

(рис. 12)

(Интересно, что 2-й монитор на 1-й видеокарте пронумеровался в системе третьим.)

После активации монитора в свойствах дисплея (возможно, потребуется запуск мастера подключения мониторов, зависит от драйвера) на нём появляется фон рабочего стола.

(рис. 13)

Остаётся настроить разрешение и частоту подключения. При установке монитора ЭЛТ не забываем установить частоту развёртки не менее 70 Гц, чтобы не пользоваться 60 Гц по умолчанию. Для LCD-мониторов такое действие не нужно.

(рис. 14)

Если производители чипов (NVidia, ATI, Matrox) разные, нужно установить второй драйвер — обычно, по отзывам из других статей, они уживаются вместе (UPD: по подсказке Jeditobe и подтверждению guessss_who, Windows Vista не поддерживает одновременно драйверы разных производителей видеокарт. XP и Win7 этим не страдают.). В настройках дисплея из системы подключается нужное количество дополнительных мониторов. Результат:

(рис. 15)

В других статьях были неоднократные измерения производительности видеокарт на разъёме PCI-Express x1, в которых показано, что все видеокарты уровня ниже ATI 3850 / GF 9800 в любых режимах и играх ведут себя практически одинаково по сравнению с разъёмом PCI-Express x16 — им хватает предельного потока данных через 1 канал PCI-Express, равного 250 Мбайт/с в одну сторону (500 Мбайт/с в обе).

Приведём статью, в которой рассматривается падение производительности на 15-20% в тестах на ATI 3850 при PCIе x1, х4, х8, х16.

www.tomshardware.com/reviews/pci-express-2.0,1915-9.html

На GF 9800 GX2:

www.tomshardware.com/reviews/pci-express-2.0,1915-10.html

Статья большая; на разных страницах описано, каким образом ставились опыты.

Если для видеокарты не стоят игровые задачи или она маломощная, то решение на PCIе x1 почти не будет уступать другим решениям с более дорогой материнской платой (кроме некоторых очень требовательных приложений наподобие Microsoft Flight Simulator, Crysis, Call Of Duty 4).