Пятое поколение компьютеров

Компьютеры пятого поколения должны были стать следующим шагом, и для достижения сверхпроизводительности, — осуществлять взаимодействие неограниченного набора микропроцессоров.

Содержание

Компью́теры пятого поколения — в соответствии с идеологией развития компьютерных технологий, после четвёртого поколения, построенного на сверхбольших интегральных схемах, ожидалось создание следующего поколения, ориентированного на распределенные вычисления, одновременно считалось, что пятое поколение станет базой для создания устройств, способных к имитации мышления.

ЭВМ первого поколения

Они были ламповыми машинами 50-х годов. Их элементной базой были электровакуумные лампы. Эти ЭВМ были весьма громоздкими сооружениями, содержавшими в себе тысячи ламп, занимавшими иногда сотни квадратных метров территории, потреблявшими электроэнергию в сотни киловатт.

Например, одна из первых ЭВМ – ENIAC представляла собой огромный по объему агрегат длиной более 30 метров, содержала 18 тысяч электровакуумных ламп и потребляла около 150 киловатт электроэнергии.

Для ввода программ и данных применялись перфоленты и перфокарты. Не было монитора, клавиатуры и мышки. Использовались эти машины, главным образом, для инженерных и научных расчетов, не связанных с переработкой больших объемов данных. В 1949 году в США был создан первый полупроводниковый прибор, заменяющий электронную лампу. Он получил название транзистор.

Разница между суперкомпьютером и обычным ПК

Как и обычные ПК, суперкомпьютеры имеют широкое пользовательское применение: моделирование физических, биологических и любых других процессов: от планирования космических миссий до обкатки новых автомобильных двигателей. По мере необходимости облачный доступ к мощностям приобретают и государственные, и частные компании.

Однако с технической точки зрения между этими «поколениями» огромная разница: суперкомпьютер представляет собой целый дата-центр, потребляющий энергию наравне с небольшим подмосковным городом. Чтобы питать такое сооружение, нужна электростанция, а чтобы охлаждать — практически целая река.

Очевидно, что суперкомпьютеры неэкологичны. Для решения этого вопроса человечество исследует разные возможности: рассматриваются варианты альтернативного охлаждения, разрабатывается сверхпроводниковая база, состоящая из материалов с крайне низким электрическим сопротивлением и создаются перспективные оптические архитектуры для передачи данных.

Определенные достижения в этой сфере уже есть. Так, еще в 2010 году разработчики суперкомпьютеров Grape-DR и Alice — Токийский университет и Университет Лестера — заявили о существенной оптимизации энергопотребления. К примеру, переход на экологичную Alice сократил выбросы углерода на 800 т. А пилотный суперкомпьютер Electra от NASA за два года использования сэкономил 2 млн кВт·ч электроэнергии и более 10 млн л воды. На основе этого проекта в 2019 году NASA вместе с HP запустили в Калифорнии новую версию суперкомпьютера, которую назвали Aitken.

NVIDIA

От NVIDIA на CES все ждали одного: новых видеокарт для ноутбуков, но буквально за несколько дней до начала выставки в Сети появились слухи и о новом GPU для домашних компьютеров. И NVIDIA не подвела: показала RTX 3060.

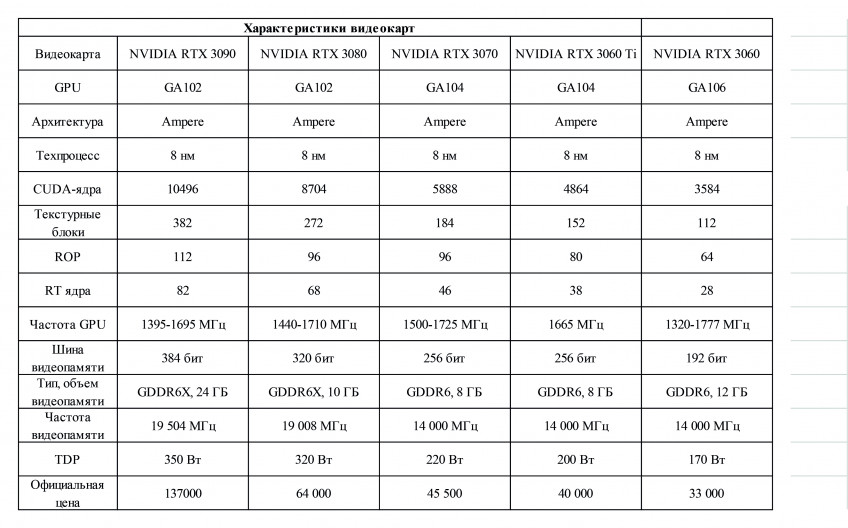

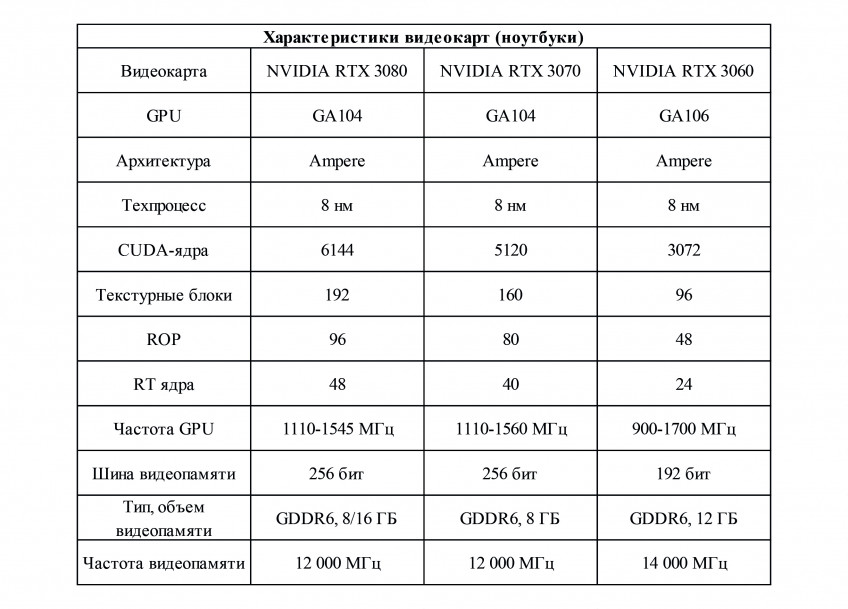

Карта оказалась на удивление крутой и одновременно спорной. Дело в том, что RTX 3060 получит 12 ГБ GDDR6. И это крайне удивительно на фоне того, что представленная буквально полтора месяца назад более мощная RTX 3060 Ti оснащена всего 8 ГБ памяти. Да что уж там, 8 ГБ стоят и на предтоповой RTX 3070. Почему NVIDIA пошла на этот шаг и как она будет объяснять это пользователям — неизвестно.

Впрочем, несмотря на 12 ГБ, RTX 3060 вряд ли окажется быстрее следующей по старшинству RTX 3060 Ti. Количество потоковых процессоров на карте уменьшилось с 4864 до 3584 штук. Пропорционально, на 26%, сократились наборы текстурных и тензорных блоков, а также движков растеризации и рейтрейсинга. Впрочем, даже с такими вводными новая RTX 3060 по производительности должна приблизиться к RTX 2080 — и это при официальной цене в 33 000 рублей. Главный вопрос теперь в том, появится ли эта карта в магазинах по стартовой цене. Судя по курсу биткоина — вряд ли.

Впрочем, одной RTX 3060 NVIDIA на CES не обошлась — и не забыла показать то, чего от её, собственно, и ждали: мобильные видеокарты нового поколения. Ими стали RTX 3060, 3070 и 3080. В целом на этом можно было бы и закончить, если бы NVIDIA опять не преподнесла сюрприз.

Дело в том, что со времён GTX 980 — то есть уже более шести лет — NVIDIA приучала нас к тому, что никакой разницы между десктопными и ноутбучными видеокартами нет. Разумеется, на последних могло быть поменьше видеопамяти, ниже частоты, не такой высокий TDP, но структурно чипы были те же самые. А вот с этого года всё: привыкаем обратно. Мобильные версии 3000-й серии сильно отличаются от десктопных, и не в лучшую сторону. Так, к примеру, RTX 3080 Mobile скорее ближе к RTX 3070, а 3070M — к 3060 Ti. Еще один грустный момент: ни одна из карт не получила новую память GDDR6X. Однако на 3080 это постараются компенсировать увеличенным объёмом: будут версии как на 8, так и на 16 ГБ.

Также вместе с 3000-й серией NVIDIA представила сразу несколько свежих технологий. Dynamic Boost 2.0 при помощи искусственного интеллекта будет определять, чему в конкретный момент нужно больше энергии: процессору, видеокарте или видеопамяти, — и автоматически распределять между ними TDP. Примерно такую же технологию в прошлом году применила AMD в мобильных процессорах и PS5. Вторая технология, Whisper Mode 2.0, займётся контролем скорости и, соответственно, уровня шума вентиляторов в ноутбуке, причём управление на себя опять возьмёт искусственный интеллект, который будет так регулировать TDP процессора и видеокарты, чтобы общая громкость системы не превышала заданных значений. И, наконец, Resizable Bar откроет центральному процессору доступ ко всему массиву видеопамяти — ранее CPU общался с чипами последовательно, что, естественно, создавало «узкие места». К слову, технология уйдёт и в десктопный сегмент и будет поддерживаться всеми видеокартами, начиная с RTX 3060.

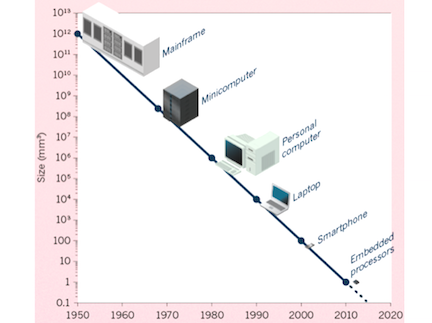

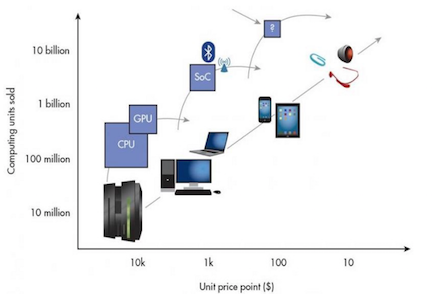

Аппаратное обеспечение: компактное, дешевое и универсальное

В мейнфрейм-эпоху только крупные организации могли позволить себе компьютер. Мини-компьютеры были доступны для организаций поменьше, а компьютеры – для домов и офисов.

Размер компьютеров уменьшается с постоянной скоростью

Сейчас мы на пороге новой эпохи, в которой процессоры и сенсоры становятся настолько дешевыми и компактными, что компьютеров скоро будет больше, чем людей.

Этому способствуют два фактора. Во-первых, неуклонный прогресс в производстве полупроводников за последние 50 лет (Закон Мура). Во-вторых, то, что Крис Андерсон называет «мирными дивидендами от войны смартфонов»: головокружительный успех смартфонов способствовал большим инвестициям в разработку процессоров и сенсоров. Загляните внутрь современного квадрокоптера, очков виртуальной реальности или любого устройства интернета вещей – что вы увидите? Правильно – главным образом компоненты смартфона.

Но в современную эпоху полупроводников всё внимание перешло от отдельных процессоров к целым узлам специальных микросхем, известным как однокристальные системы.

Цены на компьютеры стабильно снижаются

Обыкновенная однокристальная система сочетает в себе энергоэффективный ARM-процессор и специальный графический процессор, а также устройства обмена информацией, управления питанием, обработки видеосигнала и так далее.

Raspberry Pi Zero: 5-долларовый Компьютер на Linux с процессором 1 GHz

Эта инновационная архитектура позволила сбросить минимальную стоимость базовых вычислительных систем со 100 до 10 долларов за единицу. Отличным примером послужит Raspberry Pi Zero – первый 5-долларовый компьютер на Linux с частотой 1 GHz. За те же деньги можно приобрести микроконтроллер Wi-Fi, поддерживающий одну из версий Python. Совсем скоро эти микропроцессоры будут стоить меньше доллара, и мы без труда сможем встраивать их практически всюду.

Но более серьезные достижения происходят сегодня в мире высококачественных микропроцессоров. Отдельного внимания заслуживают графические процессоры, лучшие из которых производит компания NVIDIA. Графические процессоры полезны не только для обработки графики, но и при работе с алгоритмами машинного обучения, а также с устройствами виртуальной и дополненной реальности. Однако представители компании NVIDIA обещают более существенные улучшения производительности графических процессоров в ближайшем будущем.

Козырем всей сферы информационных технологий по-прежнему остаются квантовые компьютеры, которые пока существуют преимущественно в лабораториях. Но стоит сделать их коммерчески привлекательными, и это приведет к грандиозному росту производительности, прежде всего, в сфере биологии и искусственного интеллекта.

Программное обеспечение: золотой век искусственного интеллекта

Сегодня в мире программного обеспечения происходит много любопытных вещей. Хороший пример – распределенные системы. Их появление обусловлено многократным увеличением количества устройств за последние годы, что вызвало необходимость распараллеливать задания на нескольких машинах, налаживать обмен данными между устройствами и координировать их работу. Отдельного внимания заслуживают такие технологии распределенных систем, как Hadoop или Spark, предназначенные для работы с большими массивами данных. Стоит также упомянуть технологию блокчейн, обеспечивающую безопасность данных и ресурсов и впервые реализованную в криптовалюте Bitcoin.

Но, пожалуй, самые захватывающие открытия совершаются сегодня в области искусственного интеллекта (ИИ), имеющего длинную историю взлетов и падений. Еще сам Алан Тьюринг предсказывал, что к 2000 году машины будут способны имитировать людей. И хотя это предсказание пока не осуществилось, есть веские причины полагать, что ИИ наконец вступает в золотой век своего развития.

«Машинное обучение – это ключевой, революционный способ переосмысления всего, что мы делаем», – генеральный директор компании Google Сундар Пичаи.

Наибольший ажиотаж в области ИИ сосредоточен вокруг так называемого глубинного обучения – метода, который был широко освещен в рамках одного известного проекта компании Google, запущенного в 2012 году. В этом проекте была задействована высокопроизводительная сеть компьютеров, целью которой было научиться распознавать котиков на видеороликах с YouTube. Метод глубинного обучения основывается на искусственных нейронных сетях – технологии, зародившейся еще в 40-х годах прошлого века. Недавно эта технология снова стала актуальной из-за многих факторов: появления новых алгоритмов, снижения стоимости параллельных вычислений и широкого распространения больших наборов данных.

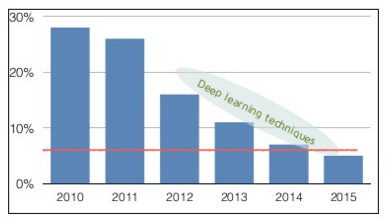

Процент ошибок в конкурсе ImageNet (красная линия соответствует показателям человека)

Остается надеяться, что глубинное обучение не станет просто очередным модным термином Силиконовой долины. Впрочем, интерес к этому методу обучения подкрепляется впечатляющими теоретическими и практическими результатами. К примеру, до введения глубинного обучения допустимый процент ошибок победителей ImageNet, известного конкурса по машинному видению, составлял 20–30 %. Но после его применения правильность алгоритмов неуклонно росла, и уже в 2015 году показатели машин превзошли показатели человека.

Многие документы, пакеты данных и инструменты программного обеспечения, связанные с глубинным обучением, находятся в открытом доступе, что позволило отдельным лицам и небольшим организациям создавать собственные высокоэффективные приложения. Компании WhatsApp Inc. потребовалось всего 50 разработчиков, чтобы создать популярный мессенджер для 900 миллионов пользователей. Для сравнения, создание мессенджеров предыдущих поколений требовало привлечения свыше тысячи (а иногда и нескольких тысяч) разработчиков. Нечто подобное теперь происходит и в области ИИ: программные средства вроде Theano и TensorFlow в сочетании с облачными дата-центрами для обучения и недорогими видеокартами для вычислений позволяют небольшим командам разработчиков создавать новаторские системы ИИ.

К примеру, ниже представлен небольшой проект одного программиста с использованием TensorFlow для преобразования черно-белых фото в цветные:

Слева направо: черно-белое фото, преобразованное фото, цветной оригинал фото. (Источник)

А вот небольшое стартап-приложение для классификации предметов в реальном времени:

Приложение Teradeep идентифицирует предметы в реальном времени

Хм, а ведь где-то я уже это видел:

Фрагмент из фильма Терминатор 2: Судный день (1991 г.)

Одним из первых приложений с методом глубинного обучения, выпущенных крупной компанией, было удивительно умное приложение для поиска изображений Google Photos:

Поиск по фотографиям (без метаданных) с ключевой фразой «big ben»

В скором времени нас ожидает значительное повышение производительности ИИ во всех сферах программного и аппаратного обеспечения: голосовые помощники, поисковые механизмы, чат-боты, 3D сканеры, языковые переводчики, автомобили, дроны, системы диагностической визуализации и многое-многое другое.

«Легко предугадать идеи следующих 10000 стартапов: взять Х и прибавить искусственный интеллект», – Кевин Келли.

Стартапы, создающие продукцию с упором на ИИ, должны оставаться предельно сфокусированными на определенных приложениях, чтобы поддерживать конкуренцию с крупными компаниями, для которых ИИ является высшим приоритетом. Системы ИИ становятся эффективнее по мере того, как увеличивается объем собранных для них данных. Получается нечто вроде маховика, постоянно вращающегося за счет так называемого эффекта сети данных (больше пользователей → больше данных → лучше продукция → больше пользователей). К примеру, команда картографического сервиса Wase использовала эффект сети данных, чтобы сделать качество предоставляемых карт лучше, чем у их более маститых конкурентов. Всем, кто намерен использовать ИИ для своего стартапа, стоит придерживаться аналогичной стратегии.

Программное + аппаратное обеспечение: новые компьютеры

Сейчас на стадии формирования находится целый ряд перспективных платформ, которые скоро вполне могут перейти на стадию развития, так как они сочетают в себе самые последние разработки из сфер программного и аппаратного обеспечения. И хотя эти платформы могут выглядеть по-разному либо иметь разную комплектацию, у них есть одна общая черта: использование последних расширенных возможностей умной виртуализации. Рассмотрим некоторые из этих платформ:

Автомобили. Крупные информационно-технологические компании вроде Google, Apple, Uber и Tesla немало инвестируют в разработку автономных или беспилотных автомобилей. На рынке уже представлены полуавтономные автомобили Tesla Model S и вскоре ожидается выход обновленных и более совершенных моделей. Создание полностью автономного автомобиля потребует некоторого времени, однако есть основания полагать, что ждать осталось не более пяти лет. На самом деле, уже существуют разработки полностью автономных автомобилей, которые ездят не хуже, чем под управлением человека. Тем не менее, в силу многих аспектов культурного и регулятивного характера такие автомобили должны ездить намного лучше, чем управляемые человеком, чтобы быть допущенными к широкой эксплуатации.

Беспилотный автомобиль составляет схему своего окружения

Несомненно, объем инвестиций в беспилотные автомобили будет только расти. В дополнение к информационно-технологическим компаниям, крупные производители автомобилей тоже начали задумываться над автономностью. Нас ждет еще много интересных стартап-продуктов. Программные средства глубинного обучения стали настолько эффективными, что сегодня одному-единственному разработчику под силу сделать полуавтономный автомобиль.

Самодельный беспилотный автомобиль

Дроны. Современные дроны укомплектованы по последнему слову техники (в основном компонентами смартфонов и механическими деталями), но имеют относительно простое ПО. В скором времени появятся усовершенствованные модели, оснащенные компьютерным зрением и другими видами ИИ, что сделает их более безопасными, удобными в управлении и полезными. Фото- и видеосъемка с дронов будет популярной не только среди аматоров, но, что важнее, найдет и коммерческое применение. К тому же, существует немало опасных видов работ, в том числе высотных, для выполнения которых было бы гораздо безопаснее использовать дроны.

Полностью автономный полет дрона

Интернет вещей. Самые основные преимущества устройств интернета вещей – это их энергоэффективность, безопасность и удобство. Хорошими примерами первых двух характеристик могут послужить продукты Nest и Dropcam. Что касается удобства, стоит обратить внимание на устройство Echo от Amazon.

Большинство людей полагают, что Echo – это очередная маркетинговая уловка, но, воспользовавшись хотя бы раз, они удивляются, насколько удобным оказывается это устройство. Оно блестяще демонстрирует эффективность голосового управления как основы пользовательского интерфейса. Конечно, мы еще не скоро увидим роботов с универсальным интеллектом, способных поддерживать полноценный разговор. Но, как показывает Echo, компьютеры уже способны справляться с более-менее сложными голосовыми командами. По мере того как метод глубинного обучения будет совершенствоваться, компьютеры научатся лучше понимать язык.

3 основных преимущества: энергоэффективность, безопасность, удобство

Устройства интернета вещей также найдут применение в бизнес-сегменте. К примеру, устройства с сенсорами и возможностью сетевого подключения широко используются для оперативного контроля промышленного оборудования.

Носимая техника. Сегодня функциональность носимых компьютеров варьируется в зависимости от ряда факторов: емкости батареи, средств коммуникации и обработки данных. Наиболее успешные устройства обычно имеют весьма узкую сферу применения: к примеру, фитнес-трекинг. По мере улучшения компонентов аппаратного обеспечения носимые устройства будут, как и смартфоны, расширять свою функциональность, открывая тем самым возможности для новых приложений. Как и в случае с интернетом вещей, предполагается, что голос станет основным пользовательским интерфейсом управления носимыми устройствами.

Миниатюрный наушник с искусственным интеллектом, фрагмент из фильма «Она»

Виртуальная реальность. 2016 год будет очень интересным для развития средств VR: релиз очков виртуальной реальности Oculus Rift и HTC Vive (и, возможно, PlayStation VR) означает, что удобные и иммерсивные системы VR наконец станут общедоступными. Разработчикам устройств VR придется хорошенько постараться, чтобы не допустить возникновения у пользователей так называемого эффекта «зловещей долины», при котором чрезмерная правдоподобность робота или другого искусственного объекта вызывает неприязнь у людей-наблюдателей.

Для создания качественных систем VR требуются качественные экраны (с высоким разрешением, высокой частотой обновления и низкой инерционностью), мощные видеокарты и возможность отслеживать точное положение пользователя (предыдущие поколения систем VR могли только отслеживать поворот головы пользователя). В этом году благодаря новым устройствам пользователи впервые смогут испытать на себе полноценный эффект присутствия: все чувства настолько качественно «обманываются», что пользователь ощущает полное погружение в виртуальный мир.

Демонстрация Oculus Rift Toybox

Несомненно, очки VR продолжат развиваться и со временем будут становиться всё доступнее. Разработчикам еще предстоит немало поработать над такими аспектами, как новые инструменты представления генерируемого и/или отснятого контента VR, усовершенствование машинного зрения для отслеживания положения пользователя и получения данных о нем прямо с телефона или очков виртуальной реальности, а также распределенные серверные системы для размещения масштабных виртуальных окружений.

Создание виртуального мира в 3D формате с помощью очков VR

Дополненная реальность. Скорее всего, AR получит развитие только после VR, потому что для полноценного использования дополненной реальности потребуются все возможности виртуальной вместе с дополнительными новыми технологиями. К примеру, для полноценного объединения в одной интерактивной сцене реальных и виртуальных объектов средствам AR потребуются продвинутые технологии машинного зрения с малой задержкой.

Устройство дополненной реальности, фрагмент из фильма «Kingsman: Секретная служба»

Но, скорее всего, эпоха дополненной реальности наступит быстрее, чем вам кажется. Этот деморолик был отснят непосредственно через устройство AR Magic Leap:

Демонстрация Magic Leap: виртуальный персонаж в реальной среде

Этот деморолик был снят непосредственно через устройство Magic Leap 14 октября 2015 года. При его создании не применялись ни спецэффекты, ни композитинг.