Как скачать сайт целиком на компьютер? 8 Лучших сервисов и программ

В последнее время всемирная паутина настолько захватила людей своими возможностями. Нужно что-то найти? Легко. Сейчас даже сохранить понравившийся сайт на компьютере не тяжело.

Зачем нужно скачать сайт на компьютер целиком? обстоятельства бывают различные это и сохранение необходимой информации, и надобность посещать сайт даже когда не будет доступа во всемирную сеть.

В этом вопросе не главное, зачем нужно скачивать сайт, более важно как это сделать о чем мы с вами и поделимся.

| Название | Описание | Распространение |

| Site2Zip | Сайт, с простым и понятным интерфейсом на русском языке, сайт загружается в два клика. Без регистрации. | Бесплатно |

| Webparse | Интересный инструмент для сознания оффлайн версии сайта, Удобный и простой в использовании. Необходима регистрация. Есть мобильная версию сайта. | Бесплатно (1 скачивание) |

| Web2PDFConvert | Данный сервис может конвертировать отдельные страницы в PDF, JPG, PNG форматы. Очень удобно когда нужно сохранить рецепт или какое-нибудь руководство. | Бесплатно |

| WinHTTrack | Программка позволяет делать копии сайтов для просмотра в оффлайн режиме. Есть русская версия программы. | Бесплатно |

| Cyotek WebCopy | Мощный инструмент для загрузки сайтов на ваш компьютер | Бесплатно |

| Teleport Pro | Еще один крутой инструмент для загрузки сайтов как полностью так и отдельных его разделов на ваш ПК или внешний диск. | Бесплатно (40 запусков) Цена: $50 |

| Offline Explorer | Хорошая программа позволяющая делать до 500 одновременных копии сайтов. Очень широкий функционал с автоматизированными процессами. | Бесплатно (30 дней) Цена: 1500 руб. |

| Webcopier | Браузер для загрузки и просмотра сайтов в оффлайн режиме | Бесплатно (15 дней) Цена: $30 |

Программы для скачивания сайтов

Подобного рода оффлайн-программы позволят вам скачать указанный раздел или сайт целиком, что может понадобиться в разных случаях. Самое полезное в сохранении сайта на жестком диске, то, что он сохраняется вместе с внутренней системой ссылок.

Оффлайн-браузеры, создают копию всех доступных директорий сайта, что позволяет вам переходить по ссылкам так, как вы делаете на обычном сайте в интернет. В пределах скачанного сайта вы сможете пользоваться всеми разделами и меню.

Кроме того, программы способны распознавать скрипты, интерпретируя их, и тем самым давая возможность использовать их в скачанной копии сайта. При закачке сайта сохраняется полный список файлов вместе со ссылками на них, что дает вам, возможно, не только просматривать страницы, но также слушать музыку и даже смотреть видео.

Сервис r-tools.org

Ссылка: https://r-tools.org/

Данный сайт очень похож на первый от того же разработчика. Однако этот сервис является платным. Он содержит множество интересных функций, которые можно применять к тому или иному сайту.

Особенности сервиса r-tools:

— может извлечь любые скрипты и флеш файлы;

— многопотоковая загрузка нескольких сайтов;

— скачать сайт можно любой, начиная с 1996 г.;

— гарантированные услуги (в случае, если Вас результат не устроит, денежные затраты возмещаются администрацией);

— гибкие опции, где пользователь может что то оставить, что то убрать.

Сперва регистрируемся, после пополняем баланс и переходим в «Мои задачи». Далее нам предложат скачать ресурс полностью либо из веб-архива, действуем согласно своих потребностей. В общем все очень просто с этим сервисом.

Советы и выводы

Скопировать любой сайт в 2021 году может абсолютно каждый пользователь, который даже не знает про программирование, код и прочее – для этого есть широкий выбор сервисов. Они отлично решают вопрос скачивания одностраничных лендингов, сохраняя их работоспособность, но далеко не всегда могут справиться с сложными сайтами.

Если вам нужен качественный сайт или его копия, то рекомендуем все же обратиться к специалистам – тогда значительно повысится вероятность, что все элементы будут корректно работать, сайт – выполнять свою задачу, а трафик – приносить вам деньги.

Существует сразу несколько способов, с помощью которых можно скачать сайт целиком. Если сайт небольшой (состоящий из 1-5 веб-страниц), то можно обойтись и простым постраничным скачиванием, которое работает в каждом браузере. Для этого достаточно использовать комбинацию клавиш «Ctrl» + «S» и выбрать место, куда загрузится сайт.

Если же ваша деятельность требует регулярного скачивания многостраничных сайтов, то проще один раз установить специализированную утилиту. Во многих случаях можно обойтись и бесплатными версиями программ, так как в их функционале присутствует все необходимое. Если же вас интересуют дополнительные инструменты, придется раскошелиться на платную версию. Но не стоит надеятся на то, что все скаченные сайты можно запустить в офлайне, программы хорошо подходят для скачки сайтов на не сложных движках.

Чтобы не было сюрпризов, обязательно проверяйте работоспособность сайта перед работой со всех устройств!

Как скачать сайт кнопками Ctrl+Shift+I

Скачивать сайт полностью на компьютер можно и вручную. Но для этого нужно зайти на какой-либо сайт и нажать одновременно на клавиатуре такие клавиши – CTRL+Shift+I. После этого, с правой стороны страницы у Вас откроется код элемента сайта (Рисунок 4).

Затем перейдите в раздел «Sources» и выберете из списка тот элемент сайта, который хотите скачать на свой компьютер. Чтобы сохранить страницу сайта на компьютер нажмите кнопку – «Save as…» и поместите файл в нужную папку на компьютере.

Инструкция по использованию HTTrack: создание зеркал сайтов, клонирование страницы входа

С программой HTTrack вы можете создать копию сайта у себя на диске. Программа доступна для всех популярных платформ, посмотреть подробности об установке на разные системы, о графическом интерфейсе и ознакомиться со всеми опциями вы можете на странице https://kali.tools/?p=1198.

Далее я рассмотрю несколько примеров использования HTTrack с уклоном на пентестинг.

В плане пентестинга HTTrack может быть полезна для:

- исследования структуры сайта (подкаталоги, страницы сайта)

- поиск файлов на сайте (документы, изображения)

- поиск по документам и метаданным файлов с сайта

- клонирование страниц входа с целью последующего использования для фишинга

Создадим директорию, где мы будем сохранять скаченные зеркала сайтов:

Посмотрим абсолютный путь до только что созданной директории:

readlink -f websitesmirrors

В моём случае это /home/mial/websitesmirrors, у вас будет какой-то другой адрес – учитывайте это и заменяйте пути в приведённых мною командах на свои.

Простейщий запуск HTTrack выглядит так:

httrack адрес_сайта -O «путь/до/папки/зеркала»

- адрес_сайта – сайт, зеркало которого нужно сохранить на диск

- путь/до/папки/зеркала – папка, куда будет сохранён скаченный сайт

Я бы рекомендовал с каждым запуском программы использовать опцию -F, после которой указывать пользовательский агент:

httrack адрес_сайта -F «User Agent» -O «путь/до/папки/зеркала»

Списки строк User Agent я смотрю .

Читайте также: Windows обои, картинки, скачать 49 обои на рабочий стол. Красивые бесплатные фото компьютеров для рабочего стола

httrack https://z-oleg.com/ -F «Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36» -O «/home/mial/websitesmirrors/z-oleg.com»

Этой командой будет сделано локальное зеркало сайта с сохранением его оригинальной структуры папок и файлов.

Если вы хотите сосредоточится на файлах (документы, изображения), а не на структуре сайта, то обратите внимание на опцию -N4: все HTML страницы будут помещены в web/, изображения/другое в web/xxx, где xxx это расширения файлов (все gif будут помещены в web/gif, а .doc в web/doc)

Пример запуска с опцией -N4:

httrack https://thailandcer.ru/ -N4 -F «Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36» -O «/home/mial/websitesmirrors/thailandcer.ru/»

По умолчанию HTTrack учитывает содержимое файла robots.txt, т.е. если он запрещает доступ к папкам, документам и файлам, то HTTrack не пытается туда зайти. Для игнорирования содержимого robots.txt используется опция -s0

Пример запуска с опцией -s0:

httrack https://spryt.ru/ -s0 -N4 -F «Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2228.0 Safari/537.36» -O «/home/mial/websitesmirrors/spryt.ru/»

Для обновления уже созданного зеркала можно использовать сокращённую опцию —update, которая означает обновить зеркало, без подтверждения и которая равнозначна двум опциям -iC2.

Для продолжения создания зеркала, если процесс был прерван, можно использовать сокращённую опцию —continue (означает продолжить зеркало, без подтверждения), либо эквивалентные опции -iC1.

Способ 2. Использование онлайн-сервисов

Вот оно, самое простое решение. Сейчас много есть полезных онлайн-ресурсов для перекодирования файлов, редактирования аудиофайлов и т. п. Среди достоинств этого метода – кроссплатформенность, отсутствие необходимости захламлять свою операционную систему утилитами, которые, возможно, понадобятся лишь однажды.

Всего делов-то, зайти на такой ресурс, ввести в строку адрес интересующего сайта, нажать кнопку запуска процесса скачивания и подставить «емкость», в которую польется интересующая информация…

В теории так, но, к сожалению, подобных онлайн-ресурсов, позволяющих скачать сайт целиком, раз, два, три и… И, пожалуй, все, если говорить о бесплатной возможности сохранить копию сайта на компьютер. А за все остальное придется платить, или мириться с урезанным функционалом.

Но давайте рассмотрим примеры поближе.

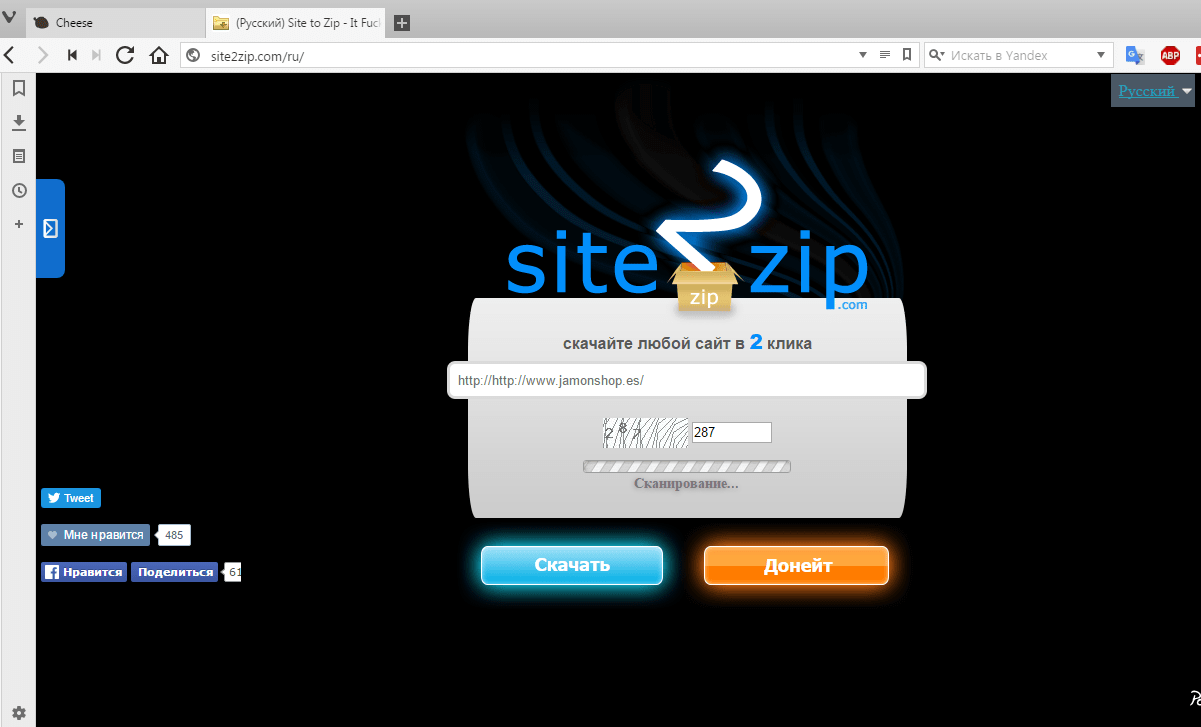

Site2Zip.com

Перестал работать в начале 2019 года.

Едва ли не единственный бесплатный и русскоязычный ресурс. Интерфейс предельно прост. В строке вводим адрес интересующего сайта, вводим капчу, нажимаем кнопку «Скачать» и ждем…

Процесс небыстрый, к тому же с первого раза может и не получиться. Если все удачно, то на выходе получим архив с сайтом.

Webparse.ru

Условно-бесплатный ресурс, позволяющий один раз воспользоваться его услугами бесплатно, после чего за скачивание сайтов придется платить.

Работает webparse.ru быстрее предыдущего ресурса, но делает это не бесплатно. В итоге получаем архив со скачанным сайтом. В настройках нет настройки глубины парсинга структуры скачиваемого сайта, поэтому убедиться, что удалось скачать сайт полностью, придется только самостоятельной сверкой оригинала и его копии.

Другие ресурсы

Среди других способов можно отметить ресурс Web2PDFConvert.com, создающий PDF-файл со страницами скачиваемого сайта. Естественно, часть функционала сайта будет утеряна. Если это допустимо, то воспользоваться данным ресурсом можно.

Еще один ресурс, позволяющий скачать сайт – r-tools.org. К сожалению, пользоваться им можно только на платной основе.

Обзор on—line сервисов для скачивания сайтов

Site2zip. Бесплатный ресурс, предоставляющий возможность сохранения веб-ресурсов всего за 3 клика, — первый необходим для ввода названия сайта, второй для ввода цифр с капчи, третий для нажатия на кнопку «Скачать».

Интересно! По утверждению разработчика этого сервиса, скачать сайт можно даже не за 3, а за 2 клика, судя по всему, подразумевается переход между полями обязательными для заполнения с помощью клавиши «Tab».

Явным недостатком данного ресурса является отсутствие каких-либо настроек, и поэтому сайт будет загружен целиком, при том что скорость сохранения довольно низкая.

Данный ресурс подойдет для скачивания небольших сайтов.

Достоинства:

+ бесплатный;

+ простой интерфейс ресурса.

Недостатки:

— отсутствие настроек;

— медленная скорость закачки.

Robotools . Платный on — line ресурс для скачивания сайтов. Имеет интуитивно понятный, русский интерфейс.

Владелец ресурса предоставляет 4 тарифных плана, в которых плата зависит от количества скачиваемых html -страниц. Тарифные планы: 500 стр – 2 у.е., 4000 стр – 8 у.е., 9000 стр – 15 у.е., 20000 стр – 25 у.е.

Если одна или несколько закачанных страниц в силу каких-либо обстоятельств стали ненужными, их можно удалить не выполняя архивирования (сохранения), тем самым сохраняя средства на балансе.

Достоинства:

+ простой интерфейс ресурса;

+ возможность одновременной закачки нескольких сайтов;

+ возможности предпросмотра скачанных сайтов на сервере, при наличии лишних страниц их можно удалить не потеряв деньги за их скачивание.

Недостатки:

Читайте также:

Как скачать сайт целиком с помощью Cyotek WebCopy

Программа WebCopy от компании Cyotek, которая стала для меня приятной находкой, может создавать качественные копии различных сайтов, вплоть до пиктограмм, что оказалось не под силу Wget. Я часто ей пользуюсь, когда возникает необходимость в загрузке какого-либо сайта и могу ее с чистой совестью вам рекомендовать.

Cyotek WebCopy — это бесплатная программа, которая сканирует HTML-разметку веб-сайта и пытаться обнаружить все связанные друг с другом ресурсы, такие как страницы, изображения, видео, загрузки файлов и т.д. Создавая таким образом, максимально приближенную к оригиналу, локальную копию веб-сайта.

Переходим на официальный сайт Cyotek, находим Cyotek WebCopy и жмем Learn More.

Нажимаем зеленую кнопку с надписью Download.

Находим в таблице актуальную версию программы и нажимаем на кнопку Download.

Затем, снова мы нажимаем Download.

После окончания загрузки установочного файла на ПК, запускаем его.

Принимаем условия лицензионного соглашения и нажимаем Далее.

Оставляем по умолчанию выбор папки для установки и нажимаем Далее.

Выбор компонентов, можно оставить Typical и нажать Далее.

Если не принципиально, оставляем создание папки в меню пуск и нажмем Далее.

Соглашаемся с созданием ярлыка программы на рабочем столе и нажимаем Далее.

И, наконец, нажимаем Установить.

Ожидаем быстрого окончания установки.

Оставляем галочку в пункте Launch Cyotek WebCopy и нажимаем Завершить.

Откроется окно программы, где нужно произвести максимально простые действия.

- В пункте Website, указываем адрес сайта, который нужно скачать;

- В строке Save folder, указываем папку, куда нужно будет скачать сайт;

- Внимательно проверяем и нажимаем на расположенную рядом кнопку Copy.

Соглашаемся с предложением создать отдельную папку для скачиваемого сайта.

И ожидаем окончания загрузки сайта на компьютер.

После загрузки сайта на ПК, появится сообщение Website copied с инфой о количестве загруженных файлов, их размере, времени начала скачивания и завершения загрузки, а также, общее время, затраченное на скачивание сайта.

Теперь, нажимаем Open Output Folder, чтобы сразу открыть папку с нашим сайтом.

А затем, находим и открываем уже знакомый файл index в формате html.

На этом пожалуй все. Увидимся на следующих страницах блога. А пока.. пока.